Einen weiteren Schritt auf dem Weg zum objektbasierten Videoediting per KI hat ein Team chinesischer Forscher vollbracht - ihr "DeepFaceVideoEditing" getaufter Algorithmus basiert auf DeepLearning-Methoden und ermöglicht die Manipulation von Gesichtsausdrücken oder auch anderen Merkmalen mittels einer einfachen Skizze.

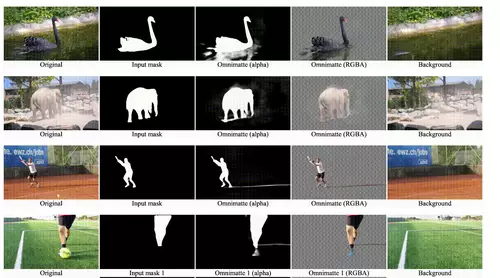

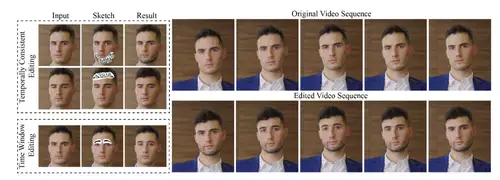

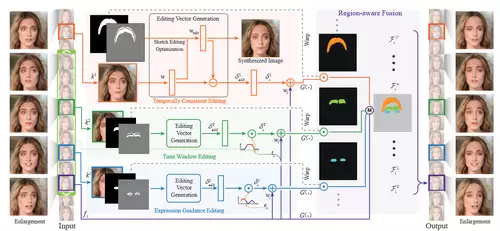

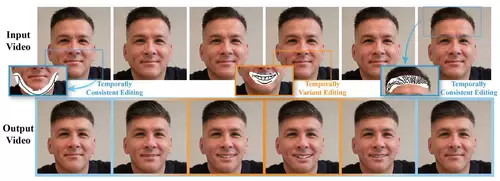

In einem Video, in dem ein Gesicht prominent vorkommt, können User mehrere Bilder auswählen und manuell eine grobe Maske definieren, in welcher die gewünschte Änderung des Gesichts skizziert wird. Diese Änderung kann sowohl den Ausdruck - etwa der Augen oder des Mundes - als auch Merkmale wie einen Bart, eine Frisur oder Augenbrauen betreffen. Es lassen sich zwei grundlegend verschiedene Arten von Änderungen realisieren: so kann entweder ein Teil eines Gesichts konsistent über die Länge des gesamten Videos geändert werden (wie zum Beispiel die Frisur oder ein Bart) oder die Änderung kann nur eine kleine Sequenz von Bildern betreffen, wie zum Beispiel eine kurzzeitige Änderung der Mimik wie etwa ein Lächeln oder ein kurzes Hochziehen der Augenbrauen oder Naserümpfen. Im folgenden Video werden die verschiedenen Möglichkeiten der Änderungen per DeepFaceVideoEditing schön demonstriert:

In Zukunft können Videoeditoren per DeepFaceVideoEditing (oder ähnliche Methoden, die noch entwickelt und dann hoffentlich auch in Editingtools integriert werden) viel leichter als bisher (z.B. per Rotoscoping) ganz gezielt die Mimiken oder das Aussehen von Schauspielern nachträglich ändern, oder zum Beispiel ein Tattoo, eine Brille oder etwa eine Narbe entfernen oder hinzufügen. Dies ermöglicht eine neue Bandbreite an Optionen in der Postproduktion, d.h. es können auch weitreichendere künstlerische Entscheidungen nach dem Dreh getroffen und relativ leicht umgesetzt werden.

DeepFaceVideoEditing nutzt unter anderem den von Nvidia entwickelten StyleGAN3 Algorithmus, der auf die Generierung und auch die Manipulation von menschlichen Gesichtern spezialisiert ist. Bekannt ist er unter anderem durch das Onlineprojekt Thispersondoesnotexist, mit dessen Hilfe beliebig realistisch aussehende Gesichter generiert werden können. Und auch dieser Algorithmus zum künstlichen Altern von Gesichtern per Photo, der auch online ausprobiert werden kann, nutzt StyleGAN.

Algorithmen zum Editing von Gesichtern in Videos sind im Grunde genommen sehr ähnlich wie die oben genannten zur Manipulation in Photos, ihre Aufgabe ist aber aufgrund der Vielzahl von leicht differierenden Einzelbildern nochmals deutlich komplexer. Zudem benötigen sie aufgrund dieser höheren Komplexität mehr Rechenpower. Aber wie der neue Algorithmus zeigt, sind die Probleme zu bewältigen und so ist es immer nur eine Frage der Zeit bis (KI-)Algorithmen, die für Photos funktionieren, auch mit Videos arbeiten. Adobe hatte sogar schon letztes Jahr im Rahmen der MAX 2021 das auf KI-Sensei Technologie beruhende Project Morpheus vorgestellt, welches die Änderung des Gesichtsausdruck einer Person per Schieberegler in Adobe Premiere ermöglichte.