Vor einigen Monaten hatten Google und Meta ihre Text-to-Video KIs vorgestellt mit Imagen bzw. Make-a-Video - diese funktionieren ganz ähnlich zu den Text-to-Image KIs wie Stable Diffsion, Midjourney oder DALL-E2, die gerade einen Boom erleben: per Textbeschreibung werden Bilder bzw. Videos erzeugt.

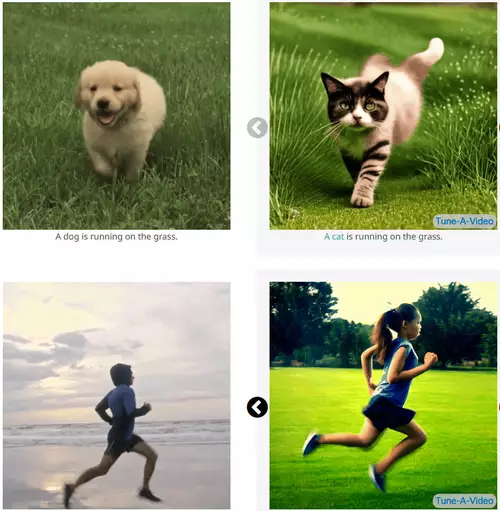

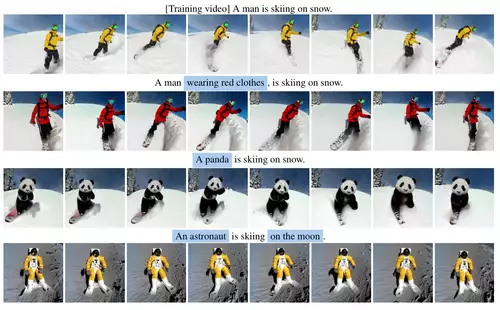

Nun haben Forscher aus Singapur eine interessante Alternative bzw. Erweiterung zu dieser Art der Videogenerierung vorgestellt: der Tune-A-Video getaufte Algorithmus kombiniert ein Beispielvideo mit einer Beschreibung des gewünschten Resultats, ähnlich wie die Image-2-Image Funktion von Stable Diffusion, bei der mittels eines Eingabebildes das Aussehen (wie Bildkomposition und Formen der Objekte) des per KI zu erzeugenden Bildes grob vorgegeben wird, während per Text der konkrete Inhalt näher definiert wird. Bei Tune-A-Video wird analog dazu ein eigenes Video eingegeben, quasi Video-2-Video - mittels einer Beschreibung können dann die einzelnen Objekte im Vordergrund ebenso wie der Hintergrund beliebig ausgetauscht werden.

Die Möglichkeiten sind weitreichend, angefangen beim objektbasiertem Videoediting - es können gezielt Objekte manipuliert werden wie im folgenden Beispiel einer Katze, die einen Hut trägt: so kann die Katze verdoppelt, ihr Gesichtsausdruck geändert, ihr Hut gegen einen anderen ausgetauscht oder auch lückenlos aus dem Video entfernt werden. Ebenso lassen sich aber auch ganze Objekte aus dem Video gegen andere auswechseln, der Hintergrund gegen einen anderen ersetzen oder das ganze Video in einem völlig anderen Darstellungsstil (zum Beispiel als Comic, Ölgemälde, Anime oder Bleistiftzeichnung) wiedergeben - jeweils inklusive aller Bewegungen.

Dies hat gegenüber der reinen Video-(bzw. Bild)generierung per Textprompt den Vorteil, daß die Art der Bewegung (wie schnell, in welchem Bewegungsstil, von wo nach wo) und die generelle Bildkomposition (wo soll sich jedes Objekt im Bild befinden, wie ist der Kamerawinkel) vorgegeben werden können, welche sonst in dieser Exaktheit nur schwer per Prompt zu beschreiben sind. Als Vorbildvideo können theoretisch genauso eigene Videos wie Clips aus beliebigen Filmen genommen werden. Letzteres öffnet natürlich die Tür zu einer unendlichen Menge an Remixes, Wiederholungen, Anlehnungen, Abwandlungen und Verfremdungen quasi auf Knopfdruck und in guter Qualität. Wie dies in Einklang mit bestehenden Urheberrechtgesetzen stehen kann oder zu bringen ist, wird die große juristische Frage der nächsten Jahre werden.

Der Tune-A-Video Algorithmus vereint mehrere getrennte Techniken wie die Animation von Objekten mittels Motion Capturing, das Design und das dynamische Rendern dieser Objekte. Er liefert momentan schon eine sehr gute Kontinuität der Bewegungen und der Objekte, wenn auch die ausgetauschten Objekte an sich oft noch recht fehlerhaft dargestellt werden und die Framerate sehr gering ist. Aber wie wir wissen, nimmt bei der aktuellen Entwicklungsgeschwindigkeit von KIs die Qualität der Ergebnisse recht rasant zu und dürfte bald ausreichend gut sein.

Aktuell steht Tune-A-Video noch nicht frei zur Verfügung - "code coming soon" heißt es jedoch auf der Projekt-Webseite.