Nahezu zeitgleich mit Runways Gen1 Video-KI hat Google eine ähnliche KI vorgestellt. Googles nennt Dreamix einen KI Video-Editor und betont dessen Fähigkeiten, per Textprompt nicht nur Videos frei zu generieren, sondern auch gezielt Objekte Videos zu verändern. Video-Editing meint in diesem Fall also nicht die Montage von Sequenzen, sondern eher die Manipulation oder Erstellung einer Videosequenz.

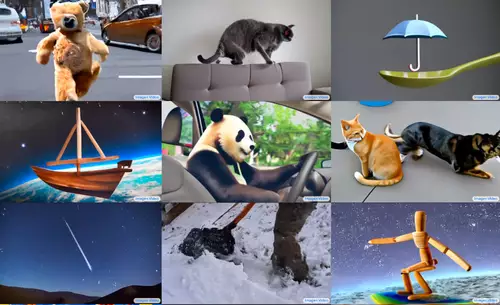

Dreamix bietet drei Methoden, um Videos zu erzeugen: Subject Driven Video Generation, Video Editing und Image-to-Video. Per Subject Driven Video Generation kann ein Objekt anhand 10-20 Fotos per Prompt animiert werden. Im Videobeispiel wird so aus Bildern eines Teddybären und der Beschreibung "ein gehender Bär" ein kurzer Clip, in welchem der Teddybär, der auf den Photos zu sehen ist, spazieren geht. Farbe, Körperhaltung, Objektgröße, Bildkomposition und Kameraposition aus dem Quellvideos werden dabei beibehalten. Es läßt sich jedoch auch ein Objekt gegen ein anderes ausgetauschen, ohne den Rest der Szene zu beeinflussen.

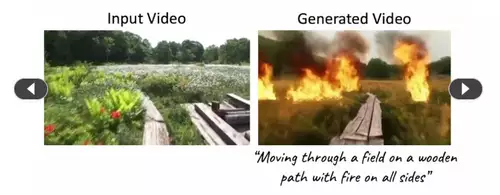

Im Video-Editing-Modus dient ein Video als Input - per Textprompt können dann gezielt Elemente manipuliert werden. So lassen sich die Bewegung oder Textur eines im Video vorkommenden Objekts ebenso wie der Hintergrund ändern. Auch das Hinzufügen von Objekten ist möglich.

Ebenso kann auch ein einzelnes Foto als Vorlage genutzt (Image-to-Video) werden. Per Prompt wird ein Objekt daraus in einem Video animiert oder auch neue Objekte hinzugefügt. Auch Kamerabewegungen sind in der neuen Szene möglich oder eine nachträgliche Zeitrafferaufnahme.

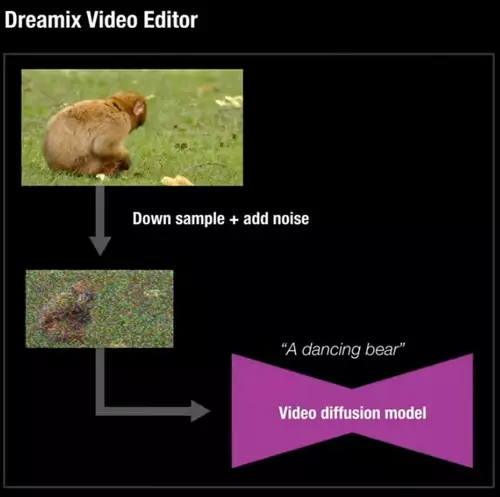

Google nutzt für Dreamix ein Video Diffusion-Modell, also eine ähnliche Methode wie aktuelle Bild-KIs wie etwa DALL-E2 oder das quelloffene Stable Diffusion. Dazu wird ein Input-Video stark herunterskaliert, mit künstlichem Rauschen versehen und dann in einem Video Diffusion-Modell verarbeitet. Per Textprompt wird daraus ein neues Video generiert, welches manche Eigenschaften des Originalvideos behält und andere gemäss dem Textinput neu rendert.

Objektbasiertes Editing: Komplexes Arbeiten ganz einfach

In schon naher Zukunft versprechen solche Video-KI zahlreiche extrem nützliche Funktionen und verheißen für die Arbeit mit Video eine Revolution. So können mit der Hilfe von Video-KIs gezielt einzelne Objekte in Videos nur per Textprompt maskiert oder manipuliert und damit VFX in einer Szene hinzugefügt werden. Alles nur per Textprompt (bzw. bald vermutlich auch per Sprachbefehl) ganz ohne ausgefuchstes Compositing. Auch könnten mit solchen KIs Animationen von Objekten ganz einfach per Bildvorlage und Textbeschreibung produziert werden. Diese universalen Fähigkeiten würde eine Vielzahl von bisherigen speziellen Funktionen in Compositing- und Videoschnittprogrammen durch einfache Textprompts ersetzen und so die bisher komplexe Arbeiten stark vereinfachen und verkürzen.