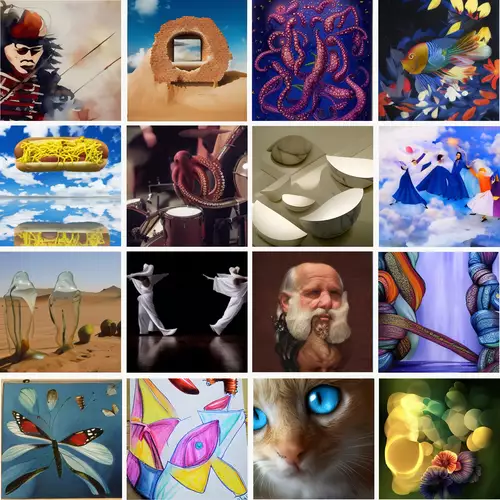

Über DALL-E 2 hatten wir ja schon berichtet, OpenAIs KI, die nur durch eine vorgegebene Beschreibung beliebig Bilder generieren kann. Meta (ehemals Facebook) hat jetzt mit "Make-A-Scene" einen ähnlichen Algorithmus vorgestellt, der es sogar ermöglicht, die Bildkomposition der KI sehr exakt zu beeinflussen und so Bilder mithilfe der KI zu gestalten.

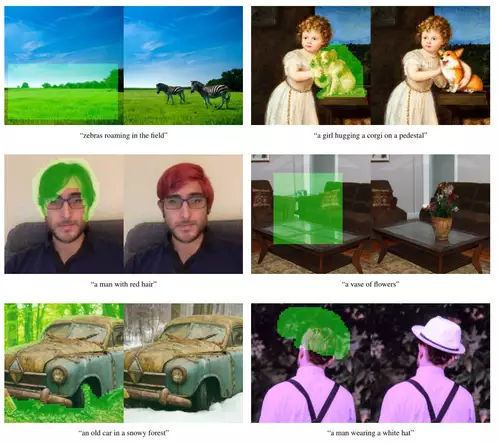

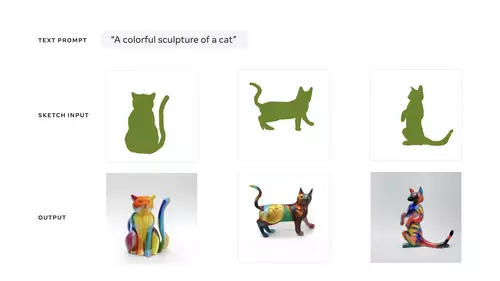

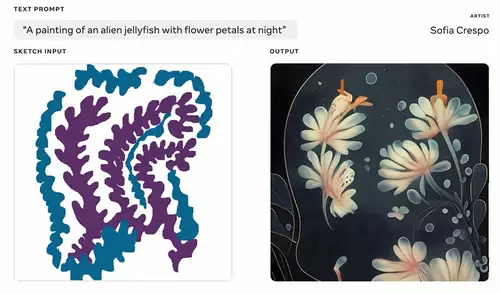

Mussten bisher in den Anweisungen an die bildgenerierende KI Wünsche bezüglich der Bildkomposition eher umständlich und ungenau ausgedrückt werden (wie z.B. "Ein Pferd links vor einem Schloss mit hohen Türmen, im Hintergrund dunkle Berge"), um Objekte an bestimmten Stellen im Bild zu platzieren oder auch die Form von Objekten näher zu bestimmen, ist dies bei Metas "Make-A-Scene" jetzt einfach mittels einer großen Skizze möglich, welche die Texteingabe ergänzt.

So ändert sich allerdings auch das Zusammenspiel von Kreativen mit der KI: wird bei einem bloßen Textprompt eher frei herumprobiert und dann das Ergebnis bestaunt - die KI spielt hier die Rolle eines Malers auf Zuruf - fungiert der neue Algorithmus mehr als eine Art Kreativ-Assistent, d.h. im Kopf des Anwenders muss schon eine Vision des Bildes bestehen, zumindest bezüglich der Bildkomposition, die KI realisiert dann passende Variationen.

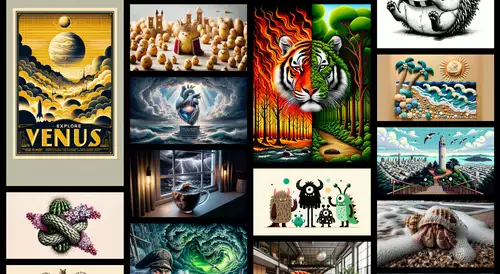

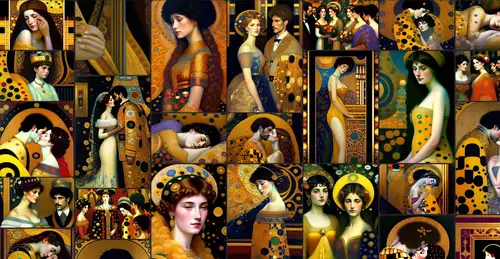

Diese Weiterentwicklung zeigt auf, welche Rolle bildgenerierende KIs zukünftig im professionellen Umfeld spielen könnten: ein Künstler entwickelt in Interaktion mit einer solchen KI eine Idee weiter oder gibt den großen Rahmen seiner Idee vor, welche die KI dann "handwerklich" ausführt. Sie erledigt dann die Arbeit, die sonst nur Künstler mit einer großen Handfertigkeit unter viel Aufwand realisieren könnten, etwa indem sie spezielle Photos schießen oder aus Bestandteilen collagieren oder Bilder in einer ganz bestimmten Technik in einem besonderen Stil malen oder zeichnen.

So wird Kunst eher zu einem "Trial und Error" Dialog zwischen Künstler und KI, bei dem der Künstler einerseits die KI anweist, seine Idee umzusetzen und sich andererseits auch überraschen läßt von den verschiedenen, in Sekundenschnelle genierten Ergebnissen.

Im folgenden Clip erzählen einige KI-Künstler, wie unterschiedlich sie "Make-a-scene" eingesetzt haben, um Kunst zu generieren:

Künstler können jetzt mittels Skizzen viel besser als bisher eine erzählerische visuelle Kontinuität zwischen mehreren Bildern oder auch eine Korrespondenz zwischen Text und Illustration herstellen. So läßt sich eine Bild-KI noch viel zielgerichteter einsetzen als bisher, hier demonstriert anhand zweier schnell realisierter Illustrationen von Kindergeschichten:

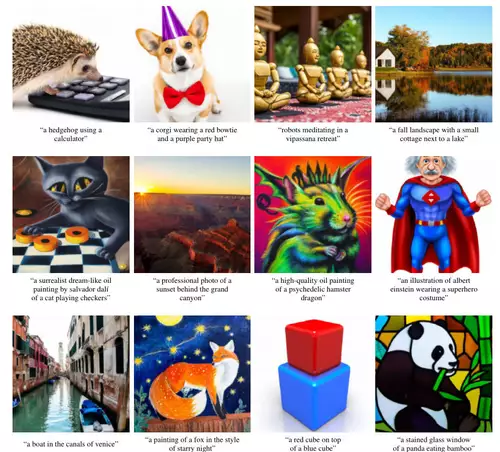

Das ganze funktioniert aber natürlich auch für Amateure, die so zu "Künstlern" (in einem völlig neuen Sinn) werden können, ohne eine spezielle Kunsttechnik zu beherrschen. Es reicht eine vage Bildidee, die dann per KI realisiert werden kann, in einem beliebigen künstlerischen Stil.

Oder in den Worten von Meta:

Wir glauben, dass wir durch wissenschaftliche Forschung und Forschungsprojekte wie Make-A-Scene die Grenzen des kreativen Ausdrucks erweitern können - unabhängig von den künstlerischen Fähigkeiten. Wir wollen es den Menschen so einfach machen, ihre Visionen in der physischen Welt und im Metaverse zum Leben zu erwecken....(Diese Forschung) könnte eines Tages völlig neue Formen des KI-gestützten Ausdrucks ermöglichen und dabei die Kreativen und ihre Visionen in den Mittelpunkt des Prozesses stellen - sei es ein Art Director, der Ideen für seine nächste kreative Kampagne entwickelt, ein Social-Media-Influencer, der personalisierte Inhalte erstellt, ein Autor, der einzigartige Illustrationen für seine Bücher und Geschichten entwickelt, oder einfach jemand, der einen lustigen, einzigartigen Gruß zum Geburtstag eines Freundes mitteilt.

Und wie wir schon in unseren Newsmeldungen zu DALL-E 2 spekuliert haben, ist es wohl nur eine Frage der Zeit, bis solche Bildtechniken Bilder auch für Videos weiterentwickelt werden, die dann ein objektbasiertes Editing von Bildsequenzen ermöglichen.

Bislang haben nur einige ausgewählte KI-Künstler sowie Mitarbeiter von Meta in begrenztem Umfang Zugang zum Projekt erhalten, die Make-A-Scene testen und Feedback geben. In Zukunft wird aber ein breiterer Zugang zu den Forschungsdemos von Meta in Aussicht gestellt.

Die Entwicklung geht ständig in rasendem Tempo weiter. Seit der Veröffentlichung des "Make-A-Scene" Forschungspapiers hat Meta noch ein neuronales Superresolution-Netzwerk integriert, das jetzt Bilder mit einer Auflösung von 2.048 x 2.048 Pixeln, also dem Vierfachen des bisherigen Projekts (und auch von DALL-E 2), erzeugt.