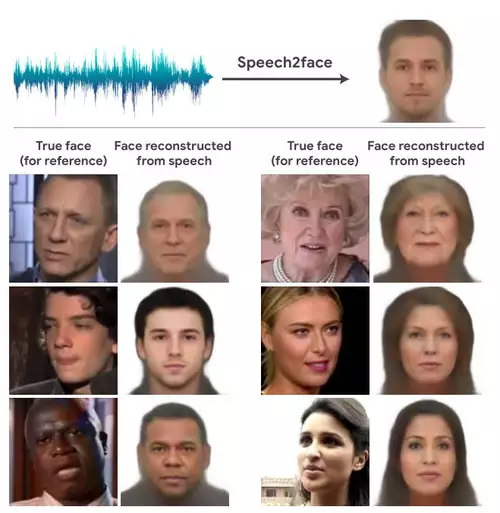

Wir sind durch einen Artikel auf Petapixel auf das extrem interessante KI Projekt "Speech2Face" aufmerksam gemacht worden, dass schon Ende 2019 veröffentlicht wurde. Der Algorithmus kann anhand eines nur ca. 4-6 Sekunden kurzen Stimmaufzeichnung das zugehörige Gesicht mit einer oft überraschend hohen Ähnlichkeit rekonstruieren.

Das tiefe neuronale Netzwerk wurde anhand von Millionen von Videos trainiert, auf denen Menschen zu sehen waren, die miteinander reden. Zum einen wurden die in den Videos vorkommenden Gesichter erkannt und zum anderen die zugehörige Stimmen per Spektrogramm charakterisiert. Anhand dieser Spektrogramme wird dann bei der Suche ein zu einer bestimmten Stimme passendes Gesicht generiert. Je länger das Sprachbeispiel ist, desto größer ist meist auch die Ähnlichkeit des Gesichts (6 Sekunden ergeben deutlich bessere Ergebnisse als 3 Sekunden Samples.

So lernte der Deep Learning Algorithmus selbständig Korrelationen zwischen dem Klang von Stimmen und dem Aussehen der Sprecher. Darauf basierend schätzt der Algorithmus dann das Alter, Geschlecht sowie weitere Merkmale des Sprechers/der Sprecherin und generiert ein passendes Gesicht.

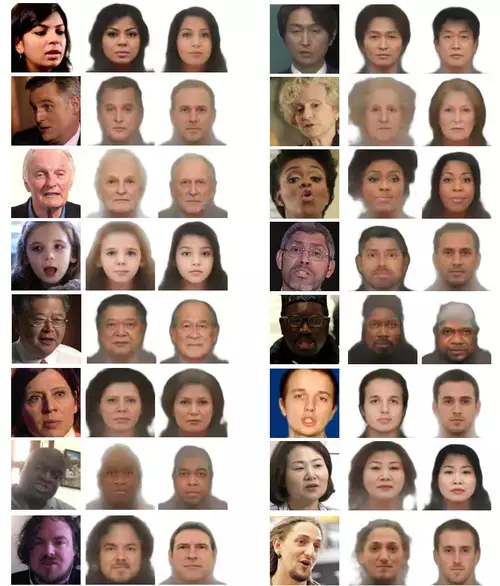

Um die Leistung der KI noch besser beurteilen zu können und das echte Gesicht mit dem generierten vergleichen zu können, wurde auch ein standardisiertes Bild des Gesichts aus der Frontalansicht mit identischer Beleuchtung einer sprechenden Person aus den Videos synthetisiert. Und auch hier zeigt sich eine oft erstaunliche Ähnlichkeit der echten mit den per Speech2Face erzeugten Gesichtern, die weit über das passende Alter und Geschlecht hinausgehen.

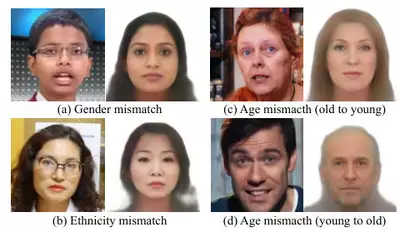

Es gab allerdings auch eine Reihe von Fällen, wo das generierte Gesicht stark vom Originalgesicht des Sprechenden abwich in Bezug auf Alter, Geschlecht oder ethnische Zugehörigkeit. Bei letzterer besonders dann, wenn eine Person nicht in der Sprache der jeweils (scheinbar) ethnischen Zugehörigkeit spricht.

Die Forscher selbst schränken deshalb auch ein, daß ihr Modell zwar statistische Korrelationen zwischen Gesichtsmerkmalen und Stimmen von Sprechern in den Trainingsdaten aufdeckt, die verwendeten Trainingsdaten (hauptsächlich einer Sammlung von Bildungsvideos von YouTube) jedoch nicht die gesamte Weltbevölkerung repräsentieren und das Modell von dieser ungleichmäßigen Verteilung der Daten beeinflusst ist. Sie empfehlen deswegen, daß bei jeder praktischen Anwendung der Methode für die beabsichtigte Nutzerpopulation repräsentative Trainingsdaten verwendet werden.

Anwendungsfälle wären zum Beispiel die automatische Generierung von zu einer Stimme passenden Avataren (auch in als Cartoon stilisierter Form) in Fällen von Onlinegesprächen, bei denen nur der Sound vorliegt. Ebenso könnten per Speech2Face auch computergenerierte Stimmen zum Beispiel von virtuellen Assistenten ein Gesicht bekommen.

Wie oft bei DeepLearning Algorithmen besteht die Gefahr, dass die auf vielen Trainingsdaten beruhende "Schätzung" des Algorithmus - so gut sie auch meist ist - unhinterfragt für wahr genommen wird. Ähnlich ist es auch bei KI Superresolution Methoden, die die Auflösung von unscharfen Bilder zwar deutlich vergrößern und dann Dinge zum Vorschein kommen lassen, die nicht per se "wahr" sind, sonder einfach nur sehr wahrscheinlich. Wer das ganze ausprobieren will, auf Github findet sich der Code.

Uns ist noch keine neue Version von Speech2Face bekannt - sollte die Methode aber weiterentwickelt werden, dann ist sie sehr wahrscheinlich aufgrund des enormen Fortschritts im Bereich DeepLearning nochmals deutlich besser als der inzwischen schon über 2 Jahre "alte" Algorithmus.