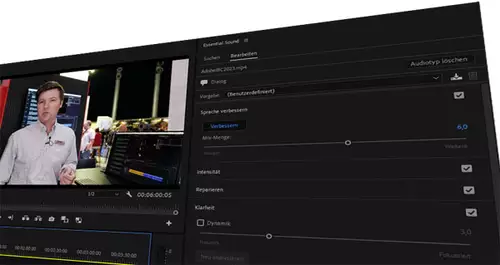

Filme in Fremdsprachen haben immer einen großen Nachteil gegenüber Filmen, welche in der jeweils lokalen Sprache gedreht wurden, denn entweder müssen sie untertitelt werden, was von vielen Zuschauern als ablenkend von der Handlung empfunden wird, oder aufwändig gedubbt werden, d.h. die Originalstimmen werden durch Sprecher ersetzt, welche die Originaldialoge in der jeweiligen Landessprache - möglichst Lippensynchron übersetzt - nachsprechen. Mit dem Vorteil, daß es keinen ablenkenden Text parallel zu lesen gibt, der allerdings mit dem Nachteil erkauft wird, daß es sich nicht mehr um die Originalstimme des/der Schauspielers/in handelt und der neue Sprechertext nicht lippensynchron wiedergegeben werden kann. Zudem ist das Ganze recht teuer, d.h. es lohnt sich nur bei größeren Filmen/Märkten, wenn mit einem ausreichend großen Erfolg gerechnet wird, um die Ausgaben für das Dubbing wieder einzuspielen.

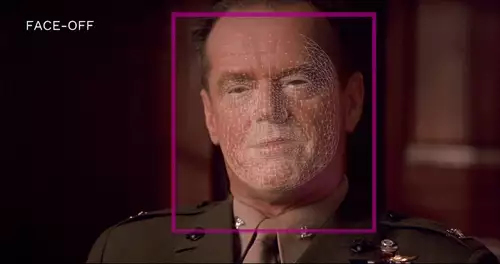

Neue Entwicklungen im Bereich DeepLearning versprechen hier eine Lösung - so kann passend zur Stimme der Synchronsprecher die Mimik und Lippenbewegungen der Schauspieler angepasst werden. Das Startup Flawless AI bietet eine solche automatische nachträgliche Anpassung der Mundbewegungen per KI passend zum Dubbing schon seit einem Jahr an.

Der Trailer enthält leider keine der nachsynchronisierten englischen Szenen, diese finden sich nur im Artikel von FXGuide

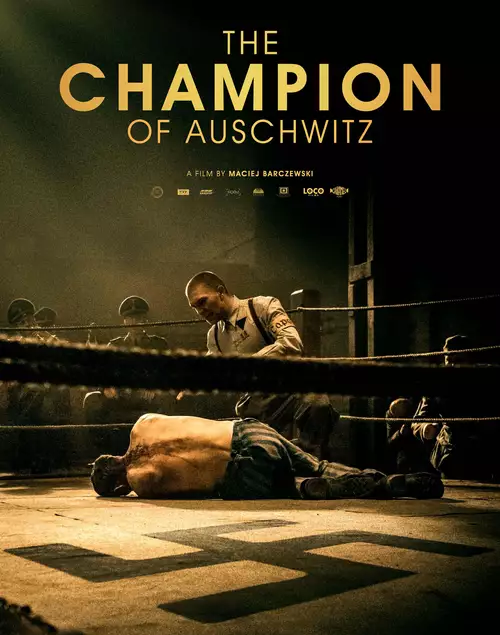

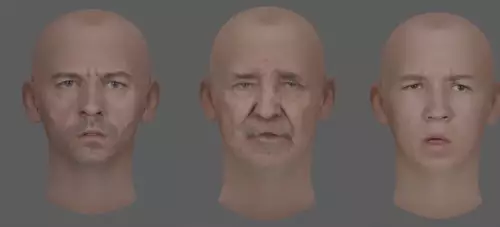

Der polnische Film "The Champion of Auschwitz" (2021) von Regisseur Maciej Barczewski ist nun der erste Kinofilm, der mit einer ähnlichen Methode synchronisiert wurde. Hier wird allerdings nicht vollkommen auf eine DeepLearning-Lösung gesetzt, welche die typischen Mundbewegungen der Schauspieler aus Filmmaterial erst lernt und dann synthetisiert (wie bei Flawless AI). Statt dessen müssen die Schauspieler selbst den Synchrontext neu einsprechen und werden dabei gefilmt. Mittels eines dank der Daten dieser Performance ermittelten digitalen Modells des Gesichts kann der Algorithmus dann die Bilder im fertigen Film ändern, um die Gesichts- und Lippenbewegungen des Schauspielers dem neuen Synchrontext anzupassen.

Die "Platon Prozess" getaufte Technik wurde von Pinscreen Technology entwickelt, der Firma eines weltführenden Experten für Neural Rendering Dr. Hao Li (übrigens ein deutscher Forscher mit taiwanesischen Wurzeln), zusammen mit der israelischen Firma Adapt Entertainment, welche die Rechte für die weltweiten englischsprachigen Vermarktung des Film erworben hatte.

Der "Platon Prozess" besteht aus einer Reihe verwobener Algorithmen und beruht auf maschinellem Lernen und neuronalem Rendering. Als Trainingsdaten für die Gesichtsneuanimation reichen die Bilder des fertigen Films. Das Einsprechen der neuen Texte erfolgt in einem neutralen Setting und wird von mehreren normalen Kameras aufgenommen, es werden keine speziellen Lichter oder Gesichtsmarker benötigt.

Die nachträgliche Änderung der Gesichtsbewegungen im fertigen Film funktioniert bei allen Arten dramatischer Beleuchtung, unterschiedlichen Kopf- und Kamerawinkeln und auch wenn der Schauspieler Spezialeffekt-Makeup trägt. Ein weiterer Vorteil ist, daß der Prozess der Lippensynchronisation auch mit großen Massen an Material funktioniert und keine aufwändige manuelle Nachbearbeitung benötigt. Im verlinkten Artikel von FXGuide finden sich einige Beispiel-Clips.

Wir sehen diese Technologie als einen ersten Schritt an; die weiteren Entwicklungsstufen sind schon vorgezeichnet, da die dafür notwendigen Methoden schon existieren und nur noch so weit in ihrer Qualität verbessert werden müssen, daß ihre Ergebnisse auch auf einer großen Leinwand bestehen können.

So besteht beim "Platon Prozess" noch - im Gegensatz zu anderen Methoden - die Notwendigkeit, daß die Schauspieler selbst ihren Synchrontext für in andere Sprachen einsprechen müssen und dabei gefilmt werden. Das ist nicht nur aufwändig, sondern auch unschön, da die meisten Schauspieler eher selten mehrere andere Sprachen akzentfrei beherrschen.

Eine Alternative dazu bietet zum Beispiel DeepDub, ein ebenfalls auf DeepLearning beruhender Startup, der den Dubbingprozess stark vereinfacht. Hier reichen nur zwei bis drei Minuten Material einer Stimme, um ein Sprechmodell zu erstellen, welches die Eigenschaften der Originalstimmen in eine andere Sprache überträgt und so auch synthetisieren kann. So können Filme mit den Stimmen der ursprünglichen Schauspieler in einer anderen Sprache gedubbt werden. Hier allerdings fehlt die nachträgliche Anpassung der Mundbewegungen, um die Performance vollkommen stimmig zu machen.

Klar ist, daß die entsprechenden Technologien für das Dubbing von Filmen sich schnell entwickeln. Dadurch vereinfachen, verbilligen und beschleunigen sie die Möglichkeit, Filme auch in anderen Ländern und damit in einem noch größeren Markt anzubieten, was eine große Chance für Filmemacher darstellt. Gerade auch weil Filme mit Untertiteln bei vielen Zuschauern nicht sehr gerne gesehen werden und ein Dubbing, besonders wenn es in der Originalstimme erfolgt, den Film besser erfahren läßt.

Bei fortschreitendem Einsatz solcher Technologien wird allerdings auch ein Problem entstehen: Synchronsprecher bzw. Schauspieler, die vielfach auch vom Dubbing von Filmen leben, könnten immer mehr Jobs durch solche Algorithmen verlieren. In Zukunft könnte der ganze Prozess per KI für viele Videos auch ganz automatisiert werden (zum Beispiel von YouTube), angefangen von der automatischen Erkennung von Sprache, über die Übersetzung, der Synthetisierung der Stimmen in einer neuen Sprache samt Anpassung der Lippenbewegung, um das ganze natürlicher aussehen zu lassen. (Danke an Frank Glencairn).