Befürchtet war es ja schon länger - jetzt ist es so weit: Die ersten Telefontrickbetrüger nutzen Stimmen-KIs, um alte Menschen durch einen vorgeblichen Notfall eines ihrer Kinder oder Enkel zu veranlassen, Geld an die Betrüger zu überweisen. Das funktioniert natürlich noch viel besser mit einer Stimme, die sich wirklich wie die des (Enkel-)Kindes anhört - und genau das ist mit modernen Stimmen-KIs, die jede Stimme täuschend echt nachahmen können, möglich.

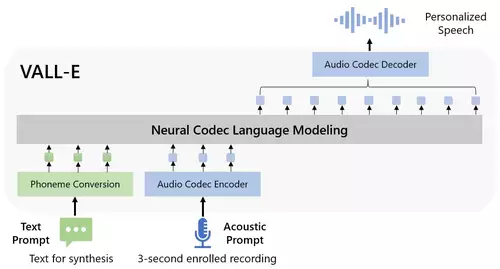

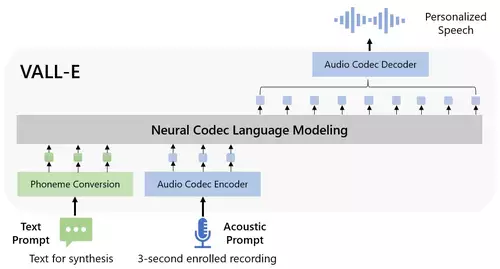

Nur wenige Sekunden lange Audioaufnahmen (je nach verwendeter KI 3-30s) einer Stimme reichen, um diese täuschend echt zu imitieren. Solche Sprachaufnahmen zu finden, ist heutzutage kein Problem: auf YouTube, TikTok oder anderen Portalen finden sich leicht Videos samt Sprachaufnahmen von sehr vielen Menschen. Über soziale Netzwerke wie Facebook oder Instagram sind dann auch schnell ältere nähere Verwandte samt zugehöriger Telefonnummer ausfindig gemacht.

Die Washington Post berichtet jetzt von genau einem solchen Fall, in welchem Eltern einen Anruf von einem angeblichen Anwalt erhielten, der ihnen mitteilte, ihr 39-jähriger Sohn habe jemanden bei einem Autounfall getötet, säße jetzt im Gefängnis und bräuchte Geld für seine Anwaltskosten. Der scheinbare Anwalt holte dann den Sohn ans Telefon, der überzeugend seinen Eltern versicherte, dass er sie liebe und jetzt dringend 21.000 Dollar für das Gericht brauche.

Welche KI die Betrüger verwendet haben, ist nicht bekannt, aber es gibt mehrere Online-Dienste wie zum Beispiel ElevenLabs und Respeecher, die das Klonen von Stimmen per KI anbieten - mal mit mehr, mal mit weniger Schutzvorrichtungen um Missbrauch zu verhindern. Diese können für einen solchen Betrug genutzt werden, und die Verantwortlichen eines solchen Betrugs zu belangen, ist schwer - sie sitzen meist in anderen Ländern und könnten nur mit Mithilfe der örtlichen Behörden (wenn überhaupt) ermittelt werden.

Telefonbanking adé?

Beunruhigend ist auch der Versuch eines Reporters, der sich erfolgreich mit seiner per KI synthetisierten Stimme über Telefonbanking in sein Konto einloggte. Das bedeutet, dass ein Authentifizierungssystem, welches nur mittels des Geburtsdatums und der Authentifizierung mittels Stimme - "Bitte sagen Sie: Meine Stimme ist mein Passwort" - jetzt nicht mehr ausreicht. Die neuen KIs ahmen Stimmen gut genug nach, um die Stimmverifikationssysteme von Banken zu täuschen. Da von vielen Menschen sowohl Stimmaufzeichnungen als auch die Geburtsdaten online leicht aufzufinden sind, sind solche Sicherheitsvorkehrungen nun leicht zu umgehen.

Bisher galt ein Stimm-Sample als extrem sicheres Ausweisverfahren - Aussagen wie beispielseweise der Bank of Scotland (bei vielen anderen Banken finden sich ähnliche Statements) sind ab sofort überholt: "Ihre Stimme ist einzigartig. Um Voice ID zu verwenden, nehmen wir Ihre Stimme auf (per Telefon), wenn Sie einen bestimmten Satz sagen... Voice ID vergleicht mehr Merkmale in Ihrer Stimme, als das menschliche Ohr wahrnehmen kann. Wir können über 100 einzigartige Merkmale in Ihrer Stimme finden. Wenn Sie uns in Zukunft anrufen, werden wir den Stimmabdruck der Voice ID mit Ihrer Stimme vergleichen. Auf diese Weise wissen wir, dass wir mit Ihnen sprechen. Die Verwendung von Voice ID für Anrufe bei Telephone Banking ist schnell, einfach und sicher."

Ein solcher Voice ID Algorithmus, der eine Stimme analysiert und daraufhin verifizieren kann, wird nun überlistet durch eine Stimmen-KI, welche ebensogut Stimmen mitsamt allen ihren Merkmalen entschlüsseln kann, anhand dieser Daten die Stimme aber auch täuschend echt simulieren kann. Noch ist kein Fall bekannt, in welchem das Telefonbanking per Stimm-KI tatsächlich gehackt wurde, aber technologisch ist die Authentifizierung per Stimme (zumindest ohne zusätzliche starke Sicherheitsmaßnahmen) jetzt überholt.

In Zukunft

Anhand solcher simulierter Stimmen sind natürlich auch mit etwas mehr Aufwand noch viel gezieltere Scams möglich - so könnte etwa die Buchhaltung einer Firma durch den Anruf des Chef dazu gebracht werden, grössere Summen zu überweisen, oder ähnliches. Der Kreativität sind keine Grenzen gesetzt, was die Einsatzmöglichkeiten von Stimmfälschungen im großen und kleinen Rahmen angeht - gerade, wenn damit Geld verdient oder eine Person diskreditiert werden kann. Wir werden vermutlich noch viel "interessantes" in dieser Richtung sehen.

Eine erste Warnung waren die Geschehnisse vom Ende Januar 2023, als User der berüchtigten Internetplattform 4chan Elvenlabs Sprach-AI dazu nutzten, Audiofakes mit den Stimmen von bekannten Persönlichkeiten zu produzieren. So zirkulierten unter anderem Clips, in welchen die Schauspielerin Emma Watson einen Auszug aus Adolf Hitlers "Mein Kampf" liest und der amerikanische Präsident Joe Biden ankündigt, Truppen in die Ukraine zu schicken - zum Teil auch noch per DeepFake als Video einigermaßen realistisch animiert.

Gibt es Schutz vor Nachahmung der eigenen Stimme?

Für die sehr nahe Zukunft bedeutet diese Entwicklung, dass bloße Stimmen nicht mehr zur Identifizierung einer Person ausreichen. Um zu vermeiden, dass die eigene Stimme nachgeahmt wird, müsste man versuchen, keine eigenen Sprachaufnahmen, die für ein Stimmensampling genutzt werden können, öffentlich zu hinterlassen. Doch das würde bedeuten, überhaupt keine Videoclips, in denen gesprochen wird, im Netz zu posten oder solche Aufnahmen durch jemand anders zu verhindern - ein in vielen Fällen unmögliches Unterfangen. Von vielen Menschen sind ohnehin bereits (Video-) samt Sprachaufnahme im Netz zu finden und nicht mehr zu löschen - das Kind ist also schon in den Brunnen gefallen. Und da schon wenige Sekunden / wenige Worte Sprachaufnahmen ausreichen, könnte auch das nicht reichen - alleine schon durch ein Telefongespräch, in welchem man mit wenigen Sätzen dem Anrufer antwortet, könnte genügend Sprachmaterial zur Simulation anfallen.

Misstraue jeder Stimme?

Dies bedeutet, dass man ab sofort jeder Audioaufnahme einer Stimme - oder sogar einem Wortwechsel in Echtzeit - misstrauen sollte, wenn das Gesagte in irgendeiner Form einen Betrug vermuten läßt oder ungewöhnlich ist, es sei denn, der Anruf kommt tatsächlich von der zur Person passenden Telefonnummer oder kann anders authentifiziert werden. Paranoides Misstrauen als Grundeinstellung - eine unschöne Aussicht. Und im gesellschaftlichen Kontext gilt das natürlich auch: ab jetzt ist keiner reinen Audioaufnahme einer bekannten Persönlichkeit mehr zu trauen, wenn deren Authentizität nicht eindeutig verifizierbar ist. Ähnliches droht demnächst, wenn die Bildqualität gut genug ist, auch Videos.