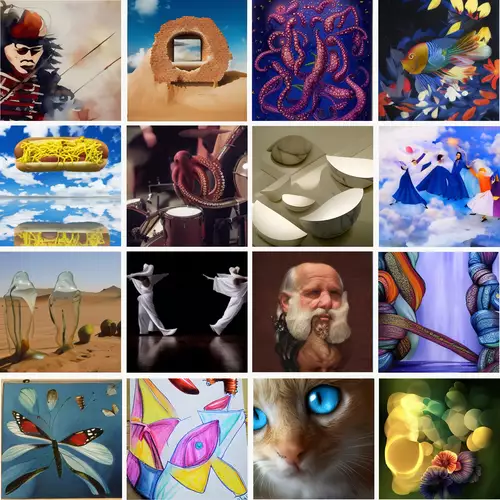

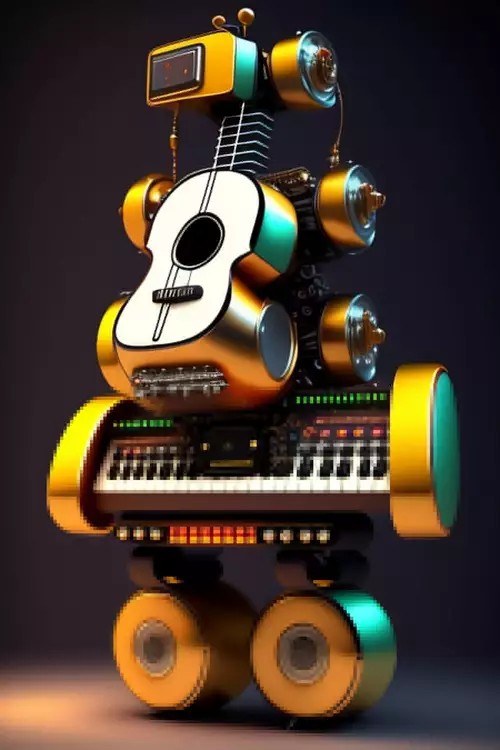

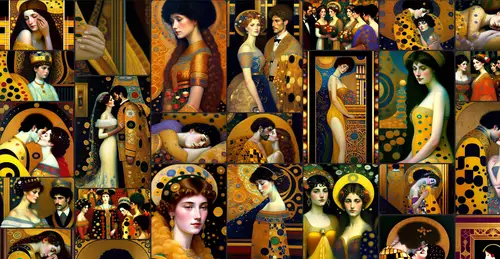

Der Boom bildgenerierender KIs, die per Prompt beliebige Bilder erzeugen, hat bei Künstlern große Ängste ausgelöst, kann doch jeder Kunst- oder Künstlerstil - egal ob Malerei, Fotografie oder digitale Kunst - oft bestechend gut durch die KI nachgeahmt werden. Die kann Bilder im entsprechenden Stil in quasi unbegrenzter Anzahl produzieren - eine unheimliche und übermächtige Konkurrenz für menschliche Künstler.

Warum können KIs Künstler so gut nachahmen?

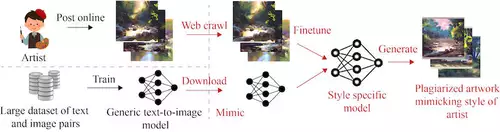

Die Grundlage für Bild-KIs bildet das Trainingsmaterial - Milliarden von Bilder samt Textbeschreibung, die aus dem Netz heruntergeladen wurden, wie etwa der LAION 5b Traingsdatensatz, den DALL-E2 und Stable Diffusion nutzen. Die KIs lernen so nicht nur die verschiedenen Objekte und indirekt zum Beispiel die optischen Gesetzmäßigkeiten der Welt kennen, sondern auch die Eigenheiten von Bildern unterschiedlicher Epochen, Materialien und eben auch die Stile spezifischer Künstler. Diese Bilder wurden bisher ungefragt aus dem Netz heruntergeladen und zum Training genutzt - die KI Entwickler beriefen sich auf das amerikanische Fair Use Prinzip, welchem zufolge für wissenschaftliche Arbeiten frei zugängliche Informationen, auch die eigentlich durch das Copyright geschützten, genutzt werden dürfen. Ob das allerdings auch für das Training solcher KIs zutrifft, wird wohl bald juristisch geklärt werden.

Die Künstlergemeinschaft versucht sich zu wehren durch Klagen und Lobbying für neue Gesetze, um das Training und auch den Einsatz von Bild-KIs wie DALL-E2, Midjourney oder Stable Diffusion zu reglementieren und eine Art Nutzungsgebühr einzufordern.

Bisher aber waren Künstler ansonsten hilflos und konnten nicht verhindern, dass ihr Werk als Trainingsmaterial für eine Bild-KI verwendet wurde so ihr ganz individueller Stil per Prompt einfach nachahmbar wurde. Keine Bilder mehr ins Netz zu stellen oder nur in geringer Auflösung ist keine echte Alternative für Künstler, die auf die Öffentlichkeit als potentielle Käufer angewiesen sind. Stable Diffusion ist den Künstlern inzwischen sogar insoweit entgegengekommen, dass in der neuesten Version 2.0 die Möglichkeit entfernt wurde, per Namensprompt den Stil eines bestimmten Künstlers zu kopieren. Allerdings sind die Künstlerstile noch im Modell enthalten und können indirekt mittels beschreibender Prompts doch noch oft herausgekitzelt werden.

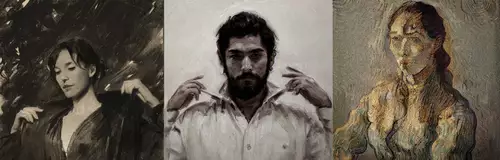

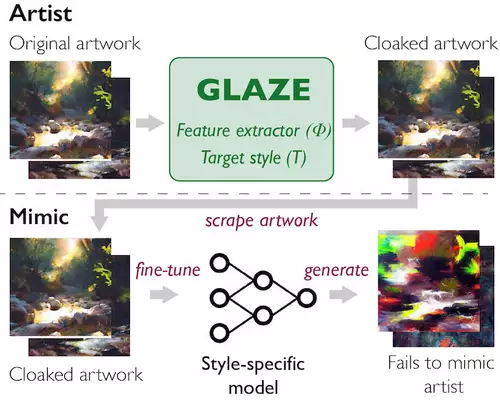

Deswegen hat ein Team von Informatikern der Universität von Chicago einen ganz neuen Weg entwickelt, damit sich Künstler gegen das unerwünschte Training ihrer eigenen Bilder wehren können. Das Glaze genannte Verfahren verändert - für Menschen nahezu unmerklich - die ins Netz gestellten Bilder, um sie so für das Training von Bild-KIs "unverdaulich" zu machen, d.h. dass die KI nicht in der Lage ist, den Stil der mit Glaze geschützten Bilder zu reproduzieren. Das Originalkunstwerk von Karla Ortiz (links), das gleiche Kunstwerk mit der Tarneinstellung "niedrig" und das gleiche Kunstwerk mit der Tarneinstellung "hoch":

Wie funktioniert Glaze?

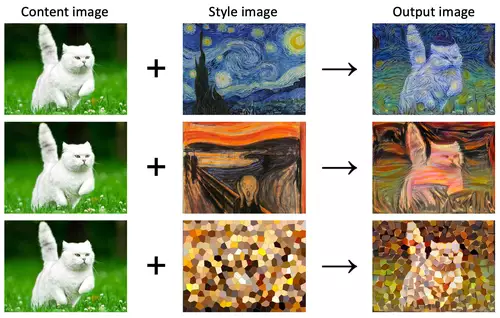

Um das Werk eines Künstlers wirksam zu tarnen, müssen die wichtigsten Merkmale, die seinen einzigartigen Stil ausmachen, bestimmt werden. Um dies zu erreichen, hatten die Forscher die Idee, die KI quasi gegen sich selbst einzusetzen. Stilübertragungsalgorithmen (Style Transfer), enge Verwandte der generativen KI-Modelle, nehmen ein vorhandenes Bild wie etwa ein Porträt, ein Stillleben oder eine Landschaft und stellen es in jedem gewünschten Stil dar, z. B. kubistisch, aquarelliert oder im Stil bekannter Künstler wie Rembrandt oder Van Gogh, ohne den Inhalt zu verändern.

Glaze nutzt einen solchen Style Transfer Algorithmus zur Analyse eines Kunstwerks und identifiziert so die spezifischen Merkmale, die sich ändern, wenn das Bild in einen anderen Stil umgewandelt wird. Dann verändert Glaze diese Merkmale gerade so weit, dass die den Stil nachahmenden KI-Modelle getäuscht werden, während die ursprüngliche Kunst für das bloße Auge nahezu unverändert bleibt. Glaze macht sich so die Tatsache zunutze, daß Bild-KIs anders als Menschen "wahrnehmen".

Wie auf den Beispielbildern unten zu sehen ist, klappte das Tarnen mittels Glaze so gut, dass die Bild-KI nach dem Training mit dem getarnten Bild nicht mehr in der Lage war, den Stil der Künstlerin nachzuahmen. Links das Originalkunstwerk von Karla Ortiz, in der Mitte ein plagiiertes Kunstwerk, das von einem KI-Modell erstellt wurde und rechts das von der KI generierte Bild nach der Tarnung des Originalkunstwerks:

Der besondere Clou: selbst wenn nur ein Teil der Bilder eines Künstlers mit Glaze getarnt ist und sowohl geschützte als auch ungeschützte Bilder zum Training einer KI verwendet werden, ist die KI nicht in Lage, den Stil eines Künstlers zu reproduzieren - sie ist quasi verwirrt durch die de-glazten Bilder. Da neue Modelle von Bild-KIs auch immer wieder mit neu aus dem Netz gesammelten Bildmaterial trainiert werden, ist es die Hoffnung der Forscher und der Künstlergemeinschaft, dass die Bild-KIs so sogar schon gelernte Künstlerstile wieder "entlernen".

Glaze kommt bald als kostenloses Tool

Die Forscher wollen in den nächsten Wochen eine freie Version von Glaze in Form eines kostenlosen Tools für Windows und macOS veröffentlichen, mittels dessen es Künstlern möglich sein soll, ihre Bilder zu tarnen, bevor sie online gestellt werden. Umfragen der Forscher unter Künstlern deuten auf eine große Nachfrage nach einem solchen Tools hin, über 90% der Künstler wollen demnach in Zukunft Glaze zum Schutz ihrer Bilder online verwenden.

Allerdings können die Forscher nicht zusichern, daßss Glaze auch in Zukunft funktionieren wird, da sich in einer Art Rüstungswettlauf auch die Gegenseite - d.h. die Unternehmen, die hinter den Bild-KIs stehen - auf die Schutzmaßnahmen einstellen können und diese umgehen könnten. Sie weisen deshalb darauf hin, dass Glaze nur eine temporäre Lösung ist, die einen gewissen Schutz bietet, aber ein dauerhafter Schutz der Künstler und ihrer Werke nur durch regulatorische Maßnahmen gelingen kann.