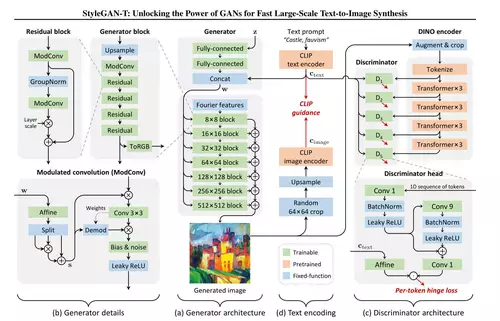

Ein Forscherteam von Nvidia und der Universität Tübingen hat eine neue (alte) Methode zur Bildgenerierung per KI vorgestellt, welche gleich zwei große Vorteile gegenüber der bisher verwendeten aufweist. Das neue, StyleGAN-T getaufte Verfahren basiert ganz klassisch auf GANs (Generative Adverserial Network), welches von Nvidia schon lange in Form von StyleGAN für mehrere interessante Anwendungen eingesetzt wurde, wie zum Beispiel schon 2018 für die Generierung beliebiger menschlicher Gesichter oder das künstliche Altern von Gesichtern.

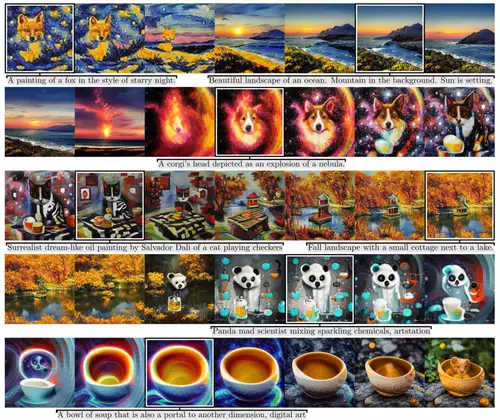

Dieses Verfahren kann dank der neuen Forschungen jetzt auch Bilder per Prompt generieren, ganz so wie die aktuellen Bild-KIs, wie etwa DALL-E2, Midjourney oder das quelloffene und deswegen am weitesten verbreitete Stable Diffusion. Diese setzen alle auf das latent Diffusion Model, um Bilder aus Text zu erzeugen. Demgegenüber zeichnet sich das neue StyleGAN-T Verfahren durch zwei besondere Eigenschaften aus: es ist deutlich schneller und kann besser zwischen den Ergebnissen unterschiedlicher Prompts morphen.

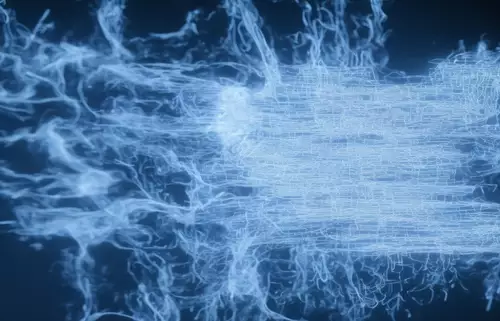

Wie schnell StyleGAN-T ist (und wie gut es nahezu stufenlos von einem zu einem anderen Bild wechseln kann), demonstriert das folgende Video sehr gut, in welchem jeder 512 x 512 Pixelausschnitt in 0.1 Sekunden - d.h. nahezu in Echtzeit - auf einer Nvidia A100 Tensor Core GPU generiert wurde:

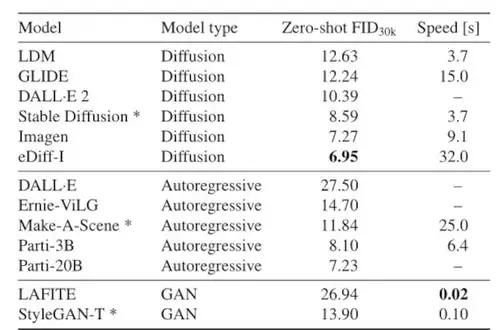

Deutlich wird der Unterschied in der Geschwindigkeit der Bildgenerierung auch in der folgenden Übersicht, einem Vergleich mit anderen Bild-KIs wie Stable Diffusion und Googles Imagen. Hier ist das neue Verfahren 37x schneller als Stable Diffusion und über 90x schneller als Imagen.

Auf schwächeren GPUs als der hochspezialisierten Nvidia A100 läuft die Bildgenerierung natürlich langsamer als 0.1 Sekunden pro Bild, aber die relative Geschwindigkeit gegenüber den per Diffusion erzeugten Bildern sollte in etwa bestehen bleiben. Zum Vergleich: auf einer Nvidia RTX 3090 dauert die Generierung von 56 Bildern mit 512 × 512 Auflösung rund 6 Sekunden. Trainiert wurde StyleGAN-T 4 Wochen lang auf 64 Nvidia A100 GPUs, d.h. mit recht begrenzter Leistung - würde mehr Ressourcen ins Training investiert, könnte die Bildqualität vermutlich noch weiter gesteigert werden.

Der zweite Vorteil der Erzeugung von Bildern per GANs ist die für die Möglichkeit, den Latent Space zu erkunden, d.h. zwischen verschiedenen Ergebnisse zu interpolieren und so visuell zwischen unterschiedlichen Ergebnissen bei gleichen oder auch anderen Textprompts zu morphen, um sie nahtlos ineinander übergehen zu lassen.

Diese allgemeine Fähigkeit von (Bild-)GANs wird recht verständlich im folgenden Clip von 2 Minute Paper demonstriert: