Bei einem als "inverses Rendering" bezeichneten Prozess wird mithilfe von Künstlicher Intelligenz (KI) das Verhalten von Licht in der realen Welt nachempfunden, so dass Forscher eine 3D-Szene aus einer Handvoll 2D-Bildern rekonstruieren können, die aus verschiedenen Winkeln aufgenommen wurden. NVIDIA hat diesen Ansatz auf neue KI-Technologie namens Neural Radiance Fields (NeRF) angewendet, die besonders schnell zu Ergebnissen kommen sollen - und das Verfahren entsprechend "Instant NeRF" getauft.

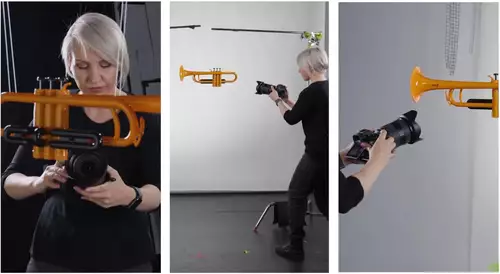

NeRFs verwenden neuronale Netze, um realistische 3D-Szenen auf der Grundlage einer Sammlung von 2D-Bildern darzustellen und zu rendern. Das neuronale Netzwerk benötigt hierfür ein paar Dutzend Bilder, die aus verschiedenen Positionen rund um die Szene aufgenommen wurden - sowie die Kameraposition für jede dieser Aufnahmen. Bei einer Szene mit Menschen oder anderen sich bewegenden Elementen ist es umso besser, je schneller diese Aufnahmen gemacht werden. Wenn sich während der 2D-Bilderfassung zu viel bewegt, wird die von der KI erzeugte 3D-Szene unscharf.

Ein NeRF füllt dann die Lücken, indem es ein kleines neuronales Netz trainiert, das die Szene rekonstruiert, indem es die Farbe des Lichts vorhersagt, das von jedem Punkt im 3D-Raum in jede Richtung strahlt. Wenn Objekte, die in einigen Bildern zu sehen sind, durch Hindernisse wie Säulen in anderen Bildern verdeckt werden, kann die Technik diese Verdeckungen sogar herausrechnen.

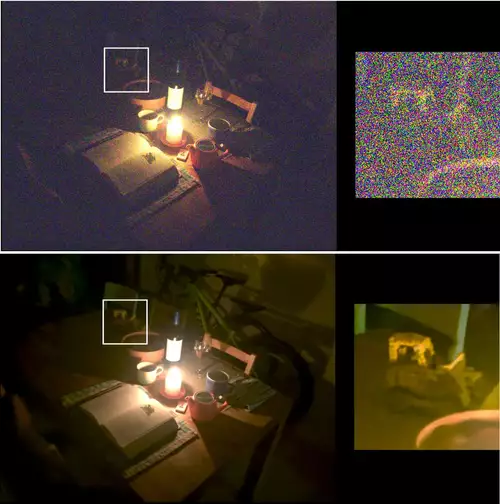

Die Erstellung einer 3D-Szene mit herkömmlichen Methoden dauert Stunden oder länger, je nach Komplexität und Auflösung der Visualisierung. Frühe NeRF-Modelle renderten gestochen scharfe Szenen ohne Artefakte in wenigen Minuten, benötigten aber immer noch Stunden für das Training.

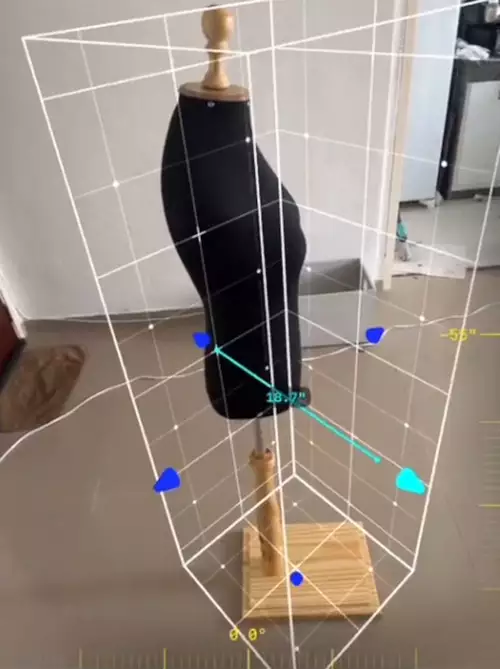

Instant NeRF hingegen verkürzt die Rendering-Zeit um mehrere Größenordnungen. Das Ergebnis soll die bislang schnellste NeRF-Technik sein, die in einigen Fällen eine mehr als 1.000-fache Beschleunigung erreicht. Das Modell benötigt nur wenige Sekunden, um mit ein paar Dutzend Fotos zu trainieren - allerdings benötigt es auch Daten zu den Kamerawinkeln, aus denen sie aufgenommen wurden. Anschließend kann es die resultierende 3D-Szene innerhalb von zehn Millisekunden rendern. Da es sich um ein leichtgewichtiges neuronales Netzwerk handelt, kann es auf einem einzigen NVIDIA-Grafikprozessor trainiert und ausgeführt werden.

Instant NeRF wurde diese Woche auf der NVIDIA GPU Technolgy Conference vorgestellt und könnte zur Erstellung von Avataren oder Szenen für virtuelle Welten, zur Erfassung von Videokonferenzteilnehmern und ihrer Umgebung in 3D oder zur Rekonstruktion von Szenen für digitale 3D-Karten verwendet werden. Damit passt diese Technologie natürlich sehr gut zum aktuellen Hype um die kommenden Metaversen.