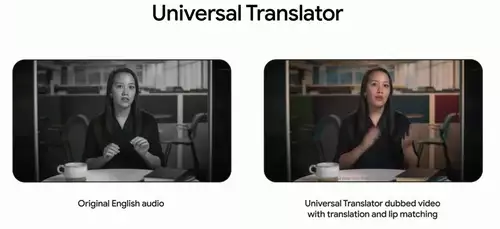

Ein neuer DeepFake-Algorithmus ermöglicht Filmemachern und Cuttern bald völlig neue Freiheiten beim Editing von Clips mit sprechenden Personen. Konnte bisher nur ein neuer Take eine Szenen retten, in welcher ein Schauspieler ein gesprochenes Wort verhaspelte oder vergaß, könnten mithilfe der neuen Methode in der Postproduktion weitreichende Änderungen am gesprochenen Text einfach nachträglich vorgenommen werden.

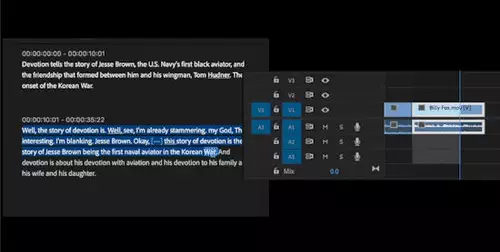

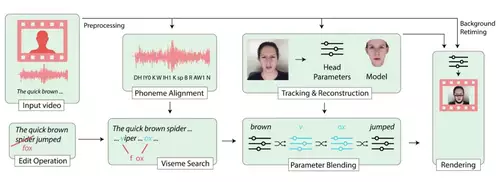

Dabei reicht es, nur mit einer Art Texteditor ein Transkript des gesprochenen Textes zu editieren, um Worte zu ändern, zu löschen oder in eine neue Reihenfolge zu bringen - der Algorithmus besorgt dann automatisch den Rest: er synthetisiert die neuen Worte mit der Stimme des jeweiligen Schauspielers und paßt analog dazu auch die Lippenbewegungen an.

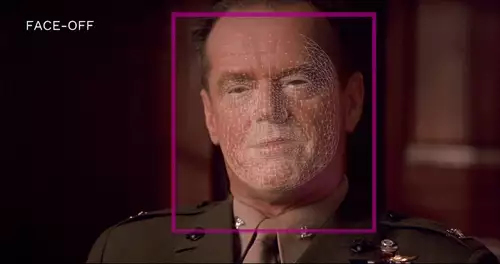

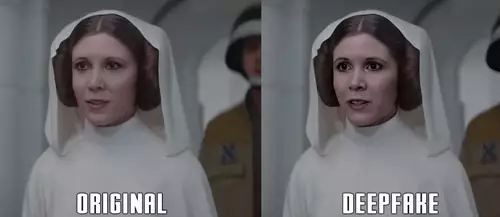

Voraussetzung für eine überzeugende Arbeit des Algorithmus der Forschern der Stanford University, des Max Planck Institute für Informatik, der Princeton University und Adobe Research ist ein Minimum von 40 Minuten an Trainingsmaterial des Sprechers sowie ein Transkript der gesprochenen Worte (das aber durch immer bessere Tools auch automatisch erstellt werden kann). Anhand des Trainingsmaterials lernt der Algorithmus, welche Gesichtsausdrücke ein Sprecher beim Sprechen jeder phonetische Silbe macht und wie er diese ausspricht - die Grundlage der synthetischen Aussprache neuer Worte. Bei Tests mit 138 Teilnehmern wurden die Manipulationen in fast 60 Prozent der Fälle als "echt" eingestuft. Die visuelle Qualität der neuen Stellen ist so gut, dass sie dem Original sehr nahe kommt, aber sie bieten auch noch viel Raum für Verbesserungen.

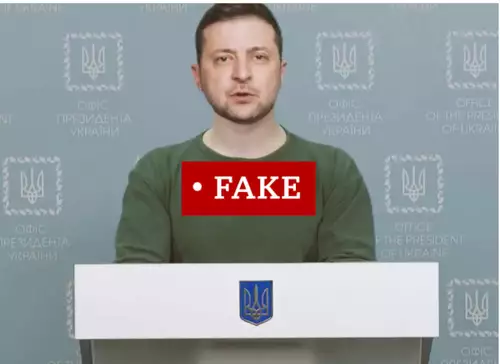

Neben dem offensichtlichen Nutzen für die professionelle Arbeit mit Videos wie zum Beispiel der nachträglichen Änderung von Dialogen ohne neue Aufnahmen, kann solch eine einfache Manipulationsmöglichkeit natürlich auch mißbraucht werden, um Videos zu fälschen. Es werden zwar auch Algorithmen entwickelt, um solche Fälschungen - seien es Bilder, Videos oder Audio - zu erkennen, aber natürlich werden im Gegenzug auch die Fakes immer realistischer - neuronale Netzwerke können sogar im Zusammenspiel trainiert werden, um immer schwerer zu identifizierende Fälschungen zu produzieren (Generative Adversarial Networks).