Roto Brush in After Effects Adé - das KI Tools Track-Anything erkennt, maskiert und trackt Objekte in Video automatisch. Wie erhofft, hat Metas frei ins Netz gestellter Algorithmus Segment Anything (SAM), welcher Objekte in Bildern erkennt und diese automatisch als einzelne Masken freistellt, zu einer wahren Explosion an darauf basierenden Tools geführt. Für Video natürlich besonders interessant ist die Möglichkeit, auch bewegte Objekte aus Videos automatisch freizustellen, um diese gezielt zu bearbeiten oder gar aus einem Video zu entfernen.

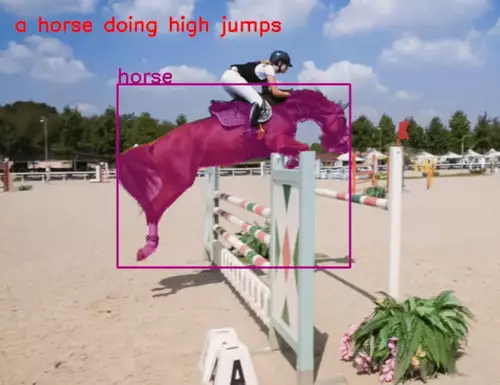

Das neue KI-Tool Track-Anything eines Teams der Visual Intelligence & Perception Lab Abteilung der chinesischen Southern University of Science and Technology in Shenzen macht genau das. Es ist ein flexibles und interaktives Werkzeug fürs Tracking und Segmentierung von Videoobjekten. Es wurde auf der Grundlage von Segment Anything entwickelt und ermöglicht Usern, nur per Klick Objekte auszuwählen, welche getrackt und maskiert werden sollen. Während des Trackings können die Benutzer die zu verfolgenden Objekte flexibel ändern oder auch den zu analysierenden Bereich korrigieren, falls es Probleme beim Tracking gibt.

Track-Anything verfolgt dabei Objekte nicht nur von Einzelbild zu Einzelbild, sondern erkennt sie auch szenenübergreifend, wie schön auf dem folgenden Demovideo anhand einer Szene aus "Avengers Civil War" zu sehen ist:

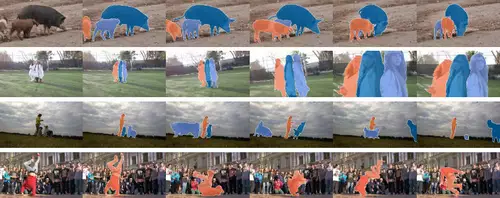

Es können auch mehrere Objekte gleichzeitig maskiert und getrackt werden - zudem kann per Inpainting ein getracktes Objekt aus dem Video entfernt werden:

Es gibt auch eine interaktive Demo auf Hugginface, mit deren Hilfe man ein eigenes Video oder einen der Beispielclips manipulieren kann. Da dort aber oft zu wenig GPU-Power zur Verfügung steht, ist der Einsatz auf dem eigenen PC oder Cloud-Space - eine starke GPU vorausgesetzt - verlässlicher.