Ein interessanter Videoclip macht gerade die Runde, der vielleicht die Zukunft der Filmproduktion zeigt. Der von Runway ML produzierte Teaser demonstriert, wie Videos durch reine Textbeschreibungen editiert und produziert werden können. So wird gezeigt, wie durch eine Reihe von Texteingaben erst eine dynamische Strassenszene importiert und mit einem FilmLook versehen wird, woraufhin ein Objekt grob mit einem Pinsel markiert und nahtlos aus der Szene entfernt wird.

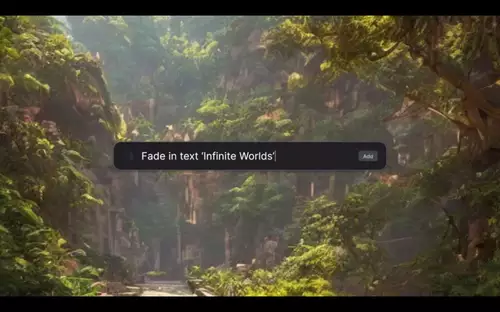

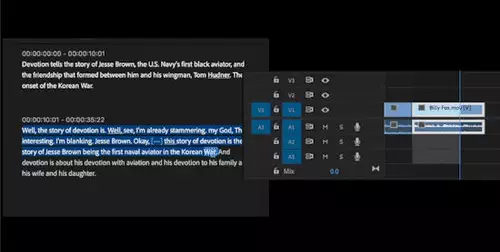

Danach ist zu sehen, wie per Textbefehl ein Bild eines "üppigen Gartens" generiert wird - ganz wie von einem KI Bildgenerator bekannt. Per "langsam vergössern" wird dann jedoch eine virtuelle Kamerazoomfahrt gestartet und ein Text langsam eingeblendet. Sehr interessant ist die dritte Szene - hier wird wie es scheint aus echtem Filmmaterial per simplem "Greenscreen charakter" Befehl eine Person maskiert, dann der Hintergrund unscharf gemacht und schließlich noch entsättigt.

Demonstriert werden damit verschiedene, bereits bekannte KI-Techniken: die Generierung von Bildern, das gezielte nahtlose Entfernen von Objekten in einem Video, die Generierung von Hintergründen, die Maskierung von Objekten samt Keying - alles durch Textbefehle.

Der Clip suggeriert, dass all diese Techniken auch beim Video-Editing greifen, wobei natürlich aus dem Teaser nicht hervorgeht, wie weit die videospezifischen Funktionen tatsächlich gehen, und ob der Clip wirklich von den genannten Techniken erzeugt oder der angepeilte Funktionsumfang per Compositing nur simuliert wurde. Der ganz große Schritt zum KI-basierten Generieren von ganzen Videosequenzen scheint noch nicht vollzogen zu sein, denn die Videosequenz am Anfang wird ja ausdrücklich importiert und nicht erstellt.

Da der Clip jedoch von Runway ML stammt, darf man davon ausgehen, dass entsprechende Möglichkeiten des textgesteuerten und objektbasierten Editings per KI demnächst auch für Video kommen. Green Screen, Inpainting und Motion Tracking ist bereits Teil des Funktionsumfangs des Online Video Editors von Runway, neu wäre also vor allem die Bedienung per Textkommandos. Damit stünde allerdings eine absolute Revolution in der Videoproduktion vor der Tür - schneller als erwartet.

Runway ML (Machine Learning) bietet schon seit einigen Jahren den Online Video Editor mit zahlreichen KI Funktionen an. Teil des Teams ist unter anderem auch der Heidelberger KI Forscher Patrick Esser, der maßgeblich auch an der Entwicklung des erst kürzlich kostenlos öffentlich zugänglich gemachten KI-Bildgenerators Stable Diffusion mitgearbeitet hat. Esser hatte vor kurzem auch schon ein Video veröffentlich, in dem der Hintergrund eines Videos dynamisch per Textbeschreibung ausgetauscht wird.

Man kann sich aktuell für eine geschlossene Betaphase anmelden, um Zugang zu den im Clip demonstrierten Text-to-Video-Funktionen im Online Video Editor zu erhalten. Wir sind extrem gespannt.