Viele Zuschauer stören sich bei fremdsprachigen Filmen, die nachträglich synchronisiert (gedubbed) sind, an den nicht zu den gehörten Lauten passenden Lippenbewegungen. Wir hatten schon letztes Jahr über den DeepLearning Algorithmus "Wav2Lip" eines indischen Forscher-Teams berichtet, welcher in der Lage war, die Lippenbewegungen eines Sprechers an die Worte aus einer beliebigen Audioaufnahme in Echtzeit anzugleichen, das klappte ganz universell mit jedem Gesicht, jeder Sprache und jeder Stimme. Das Londoner Startup Flawless AI verspricht ähnliches jetzt für Kinofilme.

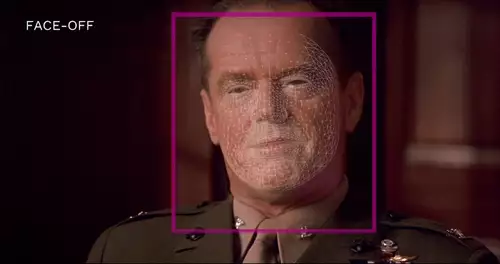

Der TrueSync getaufte DeepFake Algorithmus für Mundbewegungen soll es als weltweit erstes kommerzielles System Filmemachern ermöglichen, nachsynchronisierte Versionen ihrer Filme zu erstellen, bei denen nicht mehr visuell zu erkennen ist, dass die Sprache geändert wurde.

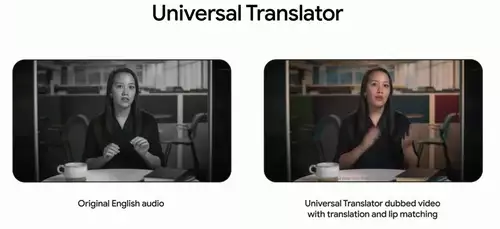

Flawless AIs True Sync Algorithmus

Laut eigenen Angaben klappt dies fotorealistisch - die Lippensynchronisation soll so nahtlos sein, dass die Mimik des Schauspielers erhalten bleibt und Zuschauer so nicht mehr von Unstimmigkeiten zwischen den Lippenbewegungen des Schauspielers und dem Text des Synchronsprechers (und den inutitiv erwarteten Lippenbewegungen) abgelenkt werden.

Demo des Flawless AIs True Sync Algorithmus:

Dazu analysiert der Algorithmus, der auf einer Forschungsarbeit von 2019 beruht und in Zusammenarbeit mit dem Max Planck Institut für Informatik entwickelt wurde, alle Mundbewegungen, welche ein Schauspieler in der Orginalversion eines Films beim Aussprechen unterschiedlicher Laute macht, um diese für die Fremdsprachenversion mit dem Synchrontext nachträglich zu synthetisieren und mit dem Rest des Gesichts möglichst lückenlos zu verschmelzen.

Uns erscheint das Ergebnis noch nicht ganz perfekt zu sein, aber eine verbesserte Version des TrueSync Algorithmus dürfte schon in Arbeit sein. Auch ist die Automatisierung nicht vollständig, zwar klappen 85% des visuellen Dubbings automatisch, aber noch müssen 15% der Arbeit manuell erledigt werden.

Interessant für die großen Filmstudios, Netflix und mehr

Flawless AI zielt, wie schon im Demovideo zu sehen ist, auf große Film- und Serienproduktionen und arbeitet mit Filmstudios wie Paramount zusammen - für die Kontakte sorgt der Mitbegründer von Flawless AI, der Filmemacher Scott Mann, der unter anderem 2015 den Film "Heist" Mit Robert De Niro gedreht hat. Der erste große Film, der die Methode einsetzt, soll in rund einem Jahr erscheinen.

Neben den großen Filmstudios wäre ein solcher Algorithmus natürlich auch für die Streaming-Anbieter wie Netflix oder Amazon Prime höchst interessant, die dann die vielen Fremdsprach-Versionen ihrer Filme und Serien ganz automatisiert (und relativ kostengünstig) visuell an die jeweilig gesprochene Sprache angleichen könnten.

Profitieren würden neben den Filmemachern und Zuschauern auch die Übersetzer von Synchrontexten, deren Arbeit deutlich erleichtert werden würde, wenn sie nicht mehr darauf achten müssten, dass die gesprochene Übersetzung möglichst nah an den Lippenbewegungen des Originals bleibt. Denn oft wird bei der Synchronisation der Dialog stark verändert, um ihn besser an die Lippenbewegungen der Schauspielers anzupassen, was den Sinn jedoch sehr entstellen kann. Allerdings müsste auch beim Lip-Syncing per KI (noch) die Länge der Übersetzung exakt mit der des Orginals stimmen und der Text von einem Synchronspecher in der Fremdsprache eingesprochen werden.

Für Filmemacher könnte die Technologie auch eine einfache Alternative zu kostspieligen Nachdrehs bieten, etwa wenn nachträglich der gesprochene Text einer Szene geändert werden soll.

Automatische Fremdsprachversionen auf YouTube?

In Zukunft wäre es auch denkbar, anderssprachige Versionen von beliebigen Clips zum Beispiel auf YouTube ganz automatisiert anzubieten. Eine automatische Transkription samt Untertiteln liefert YouTube ja schon jetzt, die nächsten Schritte sind auch schon möglich mithilfe verschiedener Deep Learning Algorithmen: die Übersetzung des transkribierten Textes in eine andere Sprache, die Sprachsynthese mit der Stimme der Originalstimme und dann die Lippensynchronisation des Videos mit dem neuen Ton.