Die Künstlerin Karen X. Cheng führt in einem kleinen Demo-Video schön vor, welche kreativen Möglichkeiten jetzt schon mit der Hilfe diverser kostenloser KI-Tools möglich sind. Im Clip wird ihre per KI generierte Kleidung dynamisch in andere Stile transformiert - sozusagen eine Modeschau im Zeitraffer.

Die neuen Kleider generierte Cheng unter Verwendung spezifischer Prompts mit der In-Painting Funktion in DALL-E 2. Dieser Algorithmus ist allerdings für Einzelbilder ausgelegt, nicht für Abfolgen von Bildern, d.h. ein damit angefertigtes Video hat keine Konsistenz, weil sich die einzelnen Bilder zu stark unterscheiden.

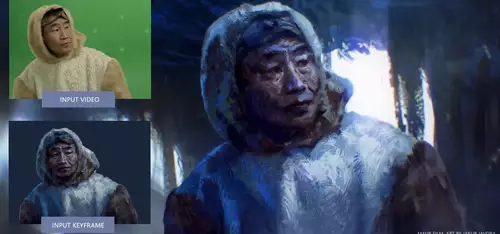

Die Lösung brachte das KI-Tool EBSynth zum Style Transfer, mit dessen Hilfe Änderungen an einem Einzelbild auf eine ganze Videosequenz übertragen werden können - zum Beispiel um Gemälde zu animieren. Damit war es anhand eines Einzelbildes eines neuen Outfits möglich, dieses dynamisch über mehrere Bilder hinweg - auch in Bewegung - korrekt über die alte Kleidung zu legen.

Als letztes Werkzeug kam DAIN zum Einsatz, ein spezielles KI-Modell zur Frameinterpolation, welches ursprünglich für Stop-Motion Animationen erschaffen wurde. Damit konnte Karen Cheng Zwischenbilder interpolieren, um den Wechsel von einem Outfit in ein anderes glatt zu gestalten und zudem noch einen Zeitlupeneffekt zu realisieren.

Das Ganze ist nur ein kleines Experiment, aber es zeigt, wie sich durch die Kombinationen mehrerer KI-Tools interessante Effekte erstellen lassen, die ohne diese Tools zwar auch möglich, aber bedeutend aufwändiger zu realisieren gewesen wären. Angefangen bei der einfachen Erschaffung von passgenauer Kleidung für eine Person per Knopfdruck nur nach einer kurzen Beschreibung, über die Übertragung dieser Änderung auf mehrere bewegte Bilder bis hin zu einer smoothen Transformation von einem Outfit in ein anderes - alles Dinge, die manuell viel Zeit gekostet hätten und jetzt dank des KI-Workflows jederzeit einfach auch in Varianten wiederholbar sind.

Wir sind bei unserer Recherche noch auf ein weiteres interessantes Tool gestoßen, das automatisch per Stable Diffusion Animationen zwischen zwei per Textprompts vorgegebenen Bildern erzeugt, wie in den folgenden Clip zu sehen:

Und noch ein weiteres Video, dieses Mal erzeugt mit Disco Diffusion: