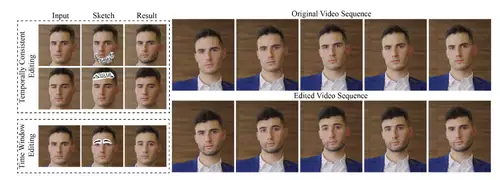

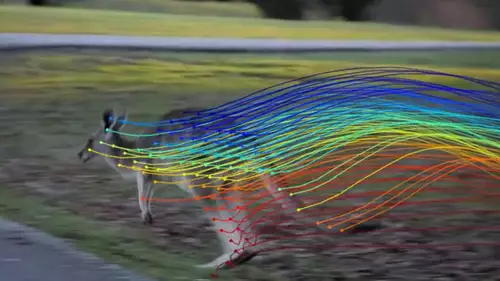

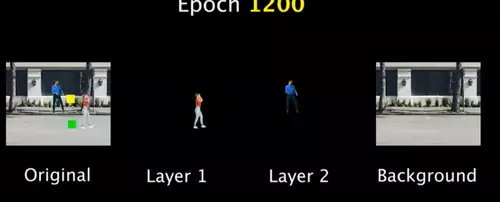

Forscher von Google und der Universität Oxford haben einen interessanten neuen AI-Algorithmus zur Manipulation von bewegten Personen in Videos vorgestellt. Der auf neuronalen Netzen beruhende Algorithmus erkennt verschiedene bewegte Objekte in einem Video und weist sie unterschiedlichen Ebenen zu - dadurch wird eine Vielzahl interessanter Effekte per Compositing der einzelnen Layer in Bezug zueinander möglich.

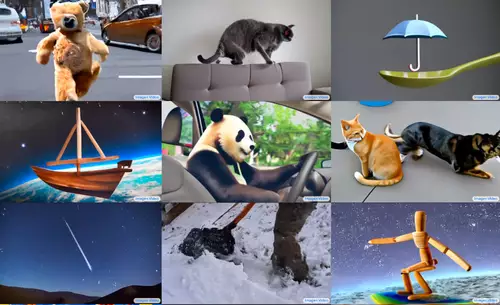

Zum Beispiel können so verschiedenen Objekte (samt ihrer Bewegung korrelierende Bildobjekte wie etwa ihr Schatten und ihre Reflektionen!) spurenlos entfernt, dupliziert, eingefroren oder per Retiming zeitlich zueinander versetzt und etwa Bewegungs-synchronisiert werden. Im Beispielvideo werden so etwa einige chaotisch auf verschiedenen Trampolins springende Personen per Time-Remapping zu einer im Takt hüpfenden Gruppe.

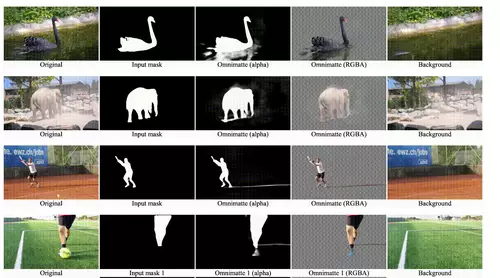

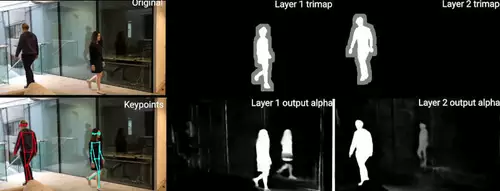

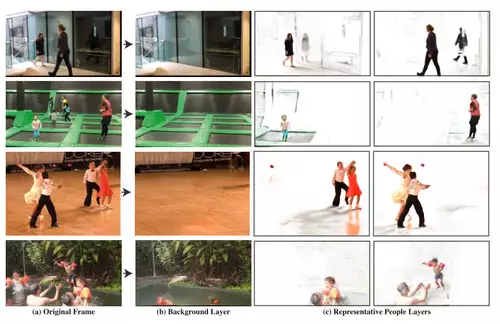

Das speziell auf die Erkennung von Personen trainierte neuronale Netz erledigt dabei eine Vielzahl von aufwändigen klassischen Compositing-Aktionen: es rekonstruiert etwa eine im Hintergrund vorbeilaufende verdeckte Person; es weist jeder Person den ihr zugehörigen Schatten und Reflektionen zu und generiert daraus eine Maske und es trennt sogar zwei sich temporär überlappende Schatten in einzelne Repräsentationen auf.

Die Methode ermöglicht das sehr einfache Erstellen bewegte Masken / Layern von Personen samt ihrer korrelierenden Spuren im Bild und deren simple Manipulation (wie etwa per Retiming) in einem Compositingprogramm. Die Möglichkeiten des intelligenten, objektbasierten Videoeditings und -compositings durch so einen Algorithmus sind gewaltig: so lassen sich - etwa zum Zweck einer besseren Bildkomposition - ganz einfach die Bewegungen von Menschen in einem Video nachträglich vollkommen verändern. Und das Ganze funktioniert auch bei einer bewegten Kamera.

Der Wermutstropfen besteht noch in der sehr geringen Videoauflösung von 448 × 256 Pixeln - um zum Einsatz im professionellen Umfeld zu gelangen, müsste der Algorithmus noch weiter optimiert werden bzw. auf stärkerer Hardware laufen, aber AI-Forschungsprojekte sind ja immer auch erst einmal Machbarkeitsstudien. Es ist nur eine Frage der Zeit bis ein für praktische Anwendungen interessanter KI-Algorithmus bis zur allgemeinen Einsatzfähigkeit weiterentwickelt wird.

Im Video des Projekts wird schön erklärt, wie das neuronale Netz trainiert wird, um bewegte Objekte samt korrelierten Effekten zu erkennen und daraus eine eigene Ebene zu erstellen - so wird auch schön der vollkommen andere Ansatz von Deep Learning im Gegensatz zu traditionellem Programmieren veranschaulicht.

Hier die Vorstellung der Methode durch Two Minute Papers:

Das Paper Layered Neural Rendering for Retiming People in Video wird auf der am 4.Dezember beginnenden SIGGRAPH Asia offiziell vorgestellt, dann sollte auch der Programm-Code auf GitHub online gehen, der in klassischen Compositingprogrammen manipulierbare Layer aus herkömmlichen Videos erzeugen soll.