Im September hatte OpenAI, die Entwickler unter anderem der Text-KI ChatGPT und der Bildgenerierungs-KI DALL-E 2, das Spracherkennungssystem Whisper vorgestellt, welches gesprochene Worte in Text transkribieren kann. Da OpenAI erfreulicherweise das zugehörige Programm samt Modell frei veröffentlicht hatte, entwickelte sich bald eine Vielzahl darauf basierender Open Source Projekte. Eines davon ist WhisperX, das von dem Computerwissenschaftler Max Bain gestartet und gerade veröffentlicht wurde. Es ist für Filmer besonders interessant, da es einige spezifische Schwächen von Whisper behebt, die dessen Nutzung als automatischer Untertitelgenerator bisher verhinderten.

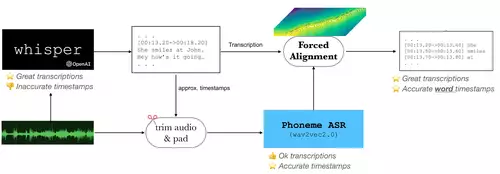

So erkennt WhisperX in der Version 2.0 (anders als das Original-Whisper) unterschiedliche Sprecher und macht diese im transkribierten Sprechertext kenntlich. In Whisper können ferner die Timestamps um mehrere Sekunden falsch liegen - um dies zu verhindern, wird der Audio-Input unter anderem vorgefiltert um zu erkennen, wann überhaupt gesprochen wird, was die Qualität erheblich verbessern soll (allerdings auch mehr Grafikkartenspeicher benötigt). In WhisperX sollen die Timestamps, welche in der Transkription anzeigen, wann ein Sprecher zu reden anfängt und aufhört, jetzt bis auf die Lautebene genau sein.

Diese Verbesserungen vereinfachen den Einsatz von Whisper zum Beispiel für die Erstellung von Untertiteln beträchtlich, da nun Dank WhispherX viel weniger manuell nachgebessert werden muss. So stimmt nicht nur das Timing jetzt genau, d.h. wenn ein Schauspieler zu sprechen anfängt, erscheint auch synchron der jeweilige Untertitel, sondern die Kennzeichnung, wer etwas sagt (wichtig zum Beispiel für die Hörgeschädigten-Fassung), erfolgt automatisch.

Derzeit werden Standardmodelle unter anderem für Englisch, Französisch, Deutsch, Spanisch, Italienisch, Japanisch, Niederländisch und Polnisch bereitgestellt. WhisperX nutzt mehrere freie Tools unabhängig, um eine robuste Segmentierung auf Wortebene mit Sprecherbeschriftungen zu erzeugen und zwar neben OpenAIs Whisper noch MetaAIs wav2vec2.0 (zuständig für die Lauterkennung auf Phonemebene) sowie pyannote.audio (für die Voice Activity Detection).

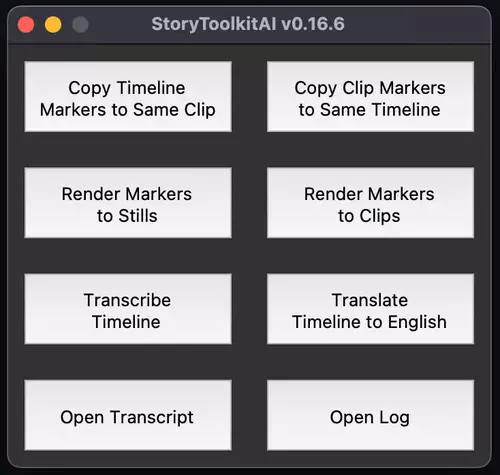

WhisperX ist wie Whisper selbst kostenlos und auf Github samt Quellcode frei verfügbar. WhisperX ist in Python geschrieben und kann - das entsprechende Wissen vorausgesetzt - per Commandline angesprochen werden. Wir gehen allerdings davon aus, daß WhisperX bald auch anwenderfreundlicher in ersten (Online) Untertitel-Tools oder -Plugins integriert werden wird.