Die sieben großen Firmen Verizon, Zeiss, RED Digital Cinema, Unity, Intel, Nvidia und Canon haben die Volumetric Format Association (VFA) gegründet, den ersten Branchenverband, der Standards für ein volumetrisches Video-Ökosystem schaffen und es überhaupt einer breiteren Öffentlichkeit bekannt machen will.

Erst durch eine Standardisierung wäre die Interoperabilität zwischen Hardware und Software verschiedener Hersteller zur Aufnahme und Bearbeitung volumetrischer Videos gewährleistet - eine Voraussetzung für eine schnelle Entwicklung entsprechender Tools, von deren Verkauf dann alle an der VFA beteiligten Firmen profitieren würden. Aber auch für die User solcher Tools wäre eine universelle Interoperabilität extrem wünschenswert.

Vier Arbeitsgruppen sind damit beauftragt, Spezifikationen zu entwickeln für die Bereiche Erfassung von volumetrischen Daten, Austausch dieser Daten, Dekodieren und Rendern sowie Metadaten.

Was ist volumetrisches Video überhaupt?

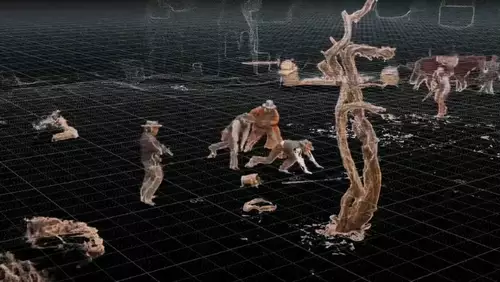

Volumetrisches Video kann verstanden werden als eine Art holographisches Video einer Szene oder eines Objekts, welches dann virtuelle Kamerafahrten durch diese ermöglicht. Erschaffen wird dieses heutzutage in dafür spezialisierten Studios, welche mit sehr vielen Kameras (und eventuell auch anderen Sensoren wie etwa Lidar) ausgestattet sind, die in einer Art Dom um die eigentliche Szene herum angeordnet werden.

Aus vielen Blickwinkeln wird eine Szene dann synchron aufgenommen, was in gewaltigen Datenraten von bis zu 600 GB pro Minute resultiert. Aus diesen Clips lassen sich anschließend bewegte Point-Clouds errechnen, was man sich wie eine errechnete 3D-Welt aus der gefilmten Szene vorstellen kann, oder klassischen Pixeln, denen zusätzlich noch räumliche Informationen zugeordnet sind (=Voxel). Anschließend kann man mit einer virtuellen Kamera in dieser Szene herumfahren und sich dabei fast völlig frei im Raum bewegen und somit nahezu jede beliebige Kameraposition in der Postproduktion festlegen.

Die dabei eingesetzten Software-Pakete sind bisher noch handgestrickt, weshalb man die Aufnahmen nicht in gängigen Schnittprogrammen außerhalb der Studios selber bearbeiten kann. Hier arbeitet jeder (unter anderem auch Microsoft) noch mit eigenen proprietären Lösungen - eine Standardisierung durch die VFA wäre deshalb ein erster wichtiger Schritt, um die Arbeit mit volumetrischem Video zu erleichtern.

Volumetrisches Video - wozu?

Die volumetrischen Point-Cloud/Videodaten können ebenso für klassisches 2D-Video (welches dann allerdings von der festen Kameraposition befreit ist) als auch für 3D-Video und zukünftig auch für holographisches Video genutzt werden. So könnte zum Beispiel bei Sport-Events oder Konzerten der User selbst bestimmen, von wo aus er das Geschehen betrachten will oder sogar seine virtuelle Kamera selbst steuern.

Dies könnte dem User, gerade per 3D, eine bisher nicht gekannte Immersion durch Interaktivität bieten - sowohl in fiktiven als auch realen Szenarien, welche so bisher nur in (VR-)Computerspielen möglich war. Je nachdem, welche Technologie zur Ansicht eingesetzt wird (2D-Monitor, 3D-Monitor, Holo-Display oder etwa VR-Brille), könnten bei diesen Videos auch die Schwächen bisheriger 3D-Technik überwunden werden.

Filmemacher erschließen sich durch volumetrisches Video neue Möglichkeiten - so kann die virtuelle Kamera "unmögliche" Kamerafahrten vollführen, wie sie bisher nur in CGI Szenen zu sehen waren. Der Regisseur kann völlig frei entscheiden, welcher Teil der Szene aus welcher Perspektive gezeigt werden soll. Im folgenden Clip werden die durch volumetrisches Video entstehenden neuen Möglichkeiten schön erklärt und demonstriert:

Volumetrisches Video per KI

Für eine Art Demokratisierung von volumetrischem Video, also einer Verringerung des bisher enorm hohen Hardware-Aufwands könnten Deep Learning Algorithmen sorgen, welche in der Lage wären, die benötigte Interpolation für Kamera-Blickwinkel zwischen den tatsächlichen Aufnahmepositionen zu errechnen.

So können schon jetzt Generative Query Networks (GQNs) durch eine Art dreidimensionales "Verständnis" einer Szene ein vollständiges 3D-Modell aus nur einer Handvoll 2D-Schnappschüssen einer Szene generieren. Das System kann sich die Szene anschließend aus jedem beliebigen Blickwinkel vorstellen und auch reproduzieren. Bemerkenswert ist auch, dass das System einzig auf Eingaben von eigenen Bildsensoren beruht und es autonom ohne menschliche Aufsicht lernt.

Damit könnte es ohne menschliches Zutun Modelle (z.B. eine Szene in einem Schnittprogramm) als 3D-Raum interpretieren. Noch arbeiten solche GQNs in engen Grenzen, die aber mit jeder neuen Generation erweitert werden.