In den letzten Jahren hat der Bereich der KI-Bilderzeugung bemerkenswerte Fortschritte erlebt, die zuletzt vor allem auf Diffusionsmodellen basieren. Solche Modelle wie Stable Diffusion oder Midjourney verdanken ihre Leistungsfähigkeit einem umfangreichen Training mit großflächigen Bilddatensätzen und einem progressiven Generierungsansatz aus Rauschen. Dieser ermöglicht die Erstellung von Bildern mit beispielloser Detailgenauigkeit und Realismus und setzt immer noch fast wöchentlich neue Maßstäbe im Bereich der generativen Modelle.

Die Anwendung von Diffusionsmodellen ist jedoch nicht nur auf Standbilder beschränkt. Ein wachsendes Interesse an der Videogenerierung hat dazu geführt, dass das Potenzial dieser Modelle bei der Erstellung dynamischer und überzeugender visueller Darstellung aktuell gerade überall auf der Welt mit extrem hohen Mittel- (sprich GPU-) Einsatz erforscht wird.

Ein spezielles Gebiet der KI-Videosynthese stellt die Generierung von menschenzentrierten Videos dar, deren Portraits künstlich animiert werden (sog. Talking Heads).

Das Ziel einer gelungenen Talking Head Synthese ist es, Feinheiten in der Vielfalt menschlicher Gesichtsbewegungen glaubhaft zu "erfinden" und darzustellen. Bisherige Ansätze legten dabei oft Einschränkungen für die endgültige Videoausgabe fest, und generieren die Gesichter der Darsteller eher statisch, was steif und unnatürlich wirkt.

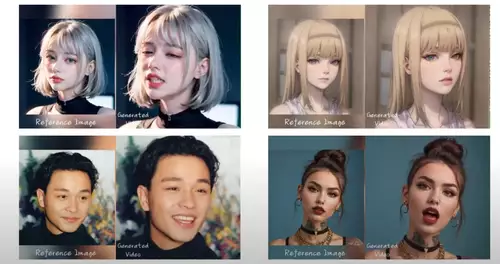

Ein chinesisches Forschungsteam aus dem Kreis der Alibaba Group, hat nun ein innovatives KI-Talking Head-Framework vorgestellt (EMO - Emote Portrait Alive), welches nicht nur ein breites Spektrum realistischer Gesichtsausdrücke mit viel Bewegung, einschließlich nuancierter Mikroausdrücke erzeugen kann. Auch werden die Emotionen für die Animation direkt aus der Audiodatei "extrahiert".

Kurz gesagt, dieses Modell erwartet als Input nur ein Portraitfoto und eine Audio-Datei mit Sprache oder Gesang und produziert daraus einen Videoclip, der das Portrait extrem realistisch sprechen oder singen lässt. Einfacher gehts wohl kaum noch, ein Photo zu animieren.

Die bislang präsentierten Ergebnisse sind dabei fast durchgehend gelungen. Auch wenn bei schwierigen Passagen der eine oder andere Fehler sofort ins Auge fällt, gibt es auch in fast jedem Videclip längere Abschnitte, in denen man nicht glauben würde, hier gerade einer KI zuzusehen.

Uns fehlen langsam die Worte für die täglichen Sprünge in der KI-Entwicklung, aber langweilig wird es immerhin bis auf absehbare Zeit wohl eher nicht...