Style Transfer war eine der ersten Deep Learning Anwendungen die der Welt andeutete, dass sich mit künstlicher Intelligenz in den nächsten Jahren so einiges verändern wird. Beim Style Transfer lässt sich ein Bild oder Video dadurch verändern, dass man einer KI ein zweites Bild zeigt, nach dessen Stil das erste Bild nachgezeichnet werden soll.

In der ersten Generation des Algorithmus hat man auf diese Art Bilder nach den Stilen berühmter Künstler wie van Gogh erzeugen lassen, danach kamen auch schon bewegte Videos an die Reihe. Tatsächlich ist es noch einmal eine größere Herausforderung auch über einen längeren Zeitraum hinweg einen Style konsistent aufrechtzuerhalten.

Doch dies ist mittlerweile auch nur noch ein Randproblem. Typische Szenenlängen von 10-20 Sekunden mit 24 fps stellen in der Regel (natürlich abhängig vom Schwierigkeitsgrad) nur noch selten ein Problem dar.

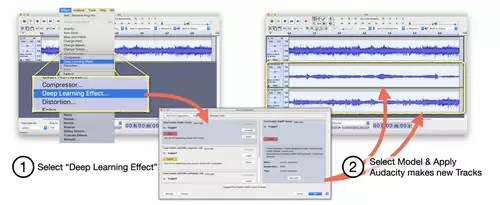

Zeit also die nächste Stufe zu zünden. In diesem Fall haben sich einige Wissenschaftler nun die Interaktivität und die Echtzeit vorgeknöpft. Echtzeit ist insofern ein Problem, dass die typischen DeepLearnig Lernphasen immer noch sehr zeit- weil rechenaufwändig sind. Das Training eines entsprechenden Modells für Video nahm auf einer Mittelklasse GPU bisher mindestens mehrere Stunden in Anspruch. Und erst mit einem fertig trainierten Modell kann üblicherweise der Style Transfer angestoßen werden.

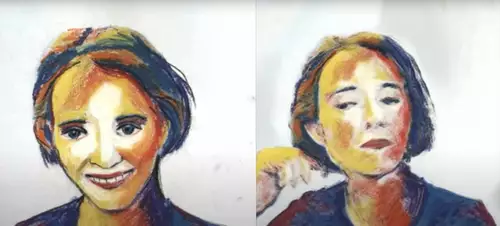

Ein neues Paper zeigt dagegen, dass "Learning while Painting" prinzipiell möglich ist. Ein Künstler kann also eine Style-Vorlage malen und bekommt währenddessen interaktiv und in Echtzeit eine Videovorschau mit laufenden Bildern angezeigt. Das dürfte für talentierte Zeichner ganz neue Workflows aufstoßen, deren Grenzen erst einmal erkundet werden wollen.

Und das ist noch nicht einmal das Ende der Fahnenstange, denn es ist zu erwarten, dass sich auf diese Weise in Zukunft auch Formen interaktiv retuschieren lassen werden. Man malt also seine Veränderungswünsche in einem Frame und diese übertragen sich immer in Echtzeit auf den gesamten Clip.

Das einzige, was uns an diesen Anwendungen noch wundert ist, dass solche Innovationen immer noch primär aus der unabhängigen Forschung stammen. Eigentlich würden wir erwarten, dass Firmen wie Adobe oder Blackmagic mit solchen Killerfeatures ihre Software-Suiten aufwerten, um sie deutlich von den Konkurrenz abzuheben. Allzulange dauert es hoffentlich nicht mehr, bis wir ähnliche Funktionen endlich auch in Premiere oder Resolve nutzen dürfen...