Der Bereich der generativen KI entwickelt sich weiterhin mit großen Schritten und Meta stellt sich in letzter Zeit als einer der besonders treibenden Motoren heraus. Ein für slashCAM besonders interessantes Feld ist dabei natürlich die Video-Generierung, für die Meta nun ein neues Modell namens Emu vorgestellt hat.

Auch wenn generative Bilder für sich genommen bereits beeindruckend fehlerfrei sein können, gelingen bis dato noch keine glaubhaften Animationen, die durchgehend konsistent wirken. Zugleich gibt es auch das grundsätzliche Problem, dass sich mit der Änderung einer Texteingabe (eines sog. Prompts) oft der gesamte Bildinhalt ändert und nicht nur ein selektiver Teil. Für beide Probleme will Emu nun gleichzeitig neue, interessante Lösungsansätze bieten.

Emu Video basiert auf Diffusionsmodellen und besitzt eine einheitliche Architektur für Videogenerierungsaufgaben, die auf eine Vielzahl von Eingaben reagieren kann: Nur Text, nur Bild und sowohl Text als auch Bild. Der Prozess besteht dabei aus zwei Stufen; Zuerst das Generieren von Bildern, die auf eine Texteingabeaufforderung konditioniert sind, und anschließend das Generieren von Videos, die sowohl auf den Text als auch auf das generierte Bild konditioniert sind.

Meistens ist ja das generierte Video anschließend nicht ganz das, was man sich vorgestellt hat. Da aber nicht jeder Lust und Zeit hat, sich intensiv mit Prompt Engineering zu befassen, wäre es deutlich leichter, wenn man im Anschluss nur noch Änderungswünsche eingibt, ohne das Video jedoch in seinen grundsätzlichen Eigenschaften zu ändern. Und genau hier kommt Emu Edit ins Spiel .

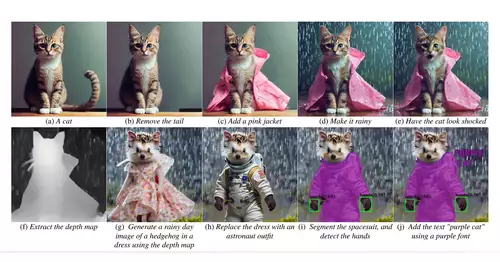

Emu Edit soll in der Lage sein, Bearbeitungen durch nachträgliche Anweisungen durchzuführen. Hiermit sollen Aufgaben wie lokale und globale Bearbeitung, Entfernen und Hinzufügen eines Hintergrunds, Farb- und Geometrietransformationen, Erkennung und Segmentierung und vieles mehr möglich sein.

Im Gegensatz zu anderen Modellen versucht Emu Edit, nur betroffene Pixel zu ändern, die für die Bearbeitungs-Anforderung relevant sind. Im Gegensatz zu vielen generativen KI-Modellen folgt Emu Edit also den Anweisungen möglichst präzise und versucht, dass Pixel im Eingabebild, die nichts mit den Anweisungen zu tun haben, unberührt bleiben.

Gelungen ist dies durch einen speziellen Trainingsdatensatz, der 10 Millionen synthetisierte Samples enthält, die jeweils ein Eingabebild, eine Beschreibung der auszuführenden Aufgabe und das Zielausgabebild enthalten. Ein weiteres mal scheint sich hier zu bewahrheiten, dass gute Daten weitaus wertvoller sind als reine Rechenleistung.

Sieht man sich die Ergebnisse an, so darf man wohl durchaus von einem weiteren Meilenstein in der KI-Entwicklung sprechen. Alle gezeigten Videos sind temporal erstaunlich konsistent und die Samples für Emu Edit lassen wirklich den grundsätzlichen Stil der Videos unberührt.

Wie wir bereits oft erwähnt haben, entwickelt sich generative KI für Bewegtbilder mit Sieben Meilen Stiefeln. Und die Transformation dieser Modelle auf fotorealistische Aufnahmen ist mit Sicherheit keine 12 Monate mehr entfernt. In diesem Sinne, schnellt euch schon mal für 2024 an...