Seit bild- und videogenerierende KI-Tools zugänglich sind, ist es einfacher als je zuvor, Bilder zu manipulieren oder sogar beliebige Motive auf Knopfdruck errechnen zu lassen und im Internet zu verbreiten. Und auch wenn nicht alles realistisch aussieht: die Frage, was eigentlich noch echt ist, drängt sich zunehmend auf. Jedes Bild, jede Tonaufnahme könnte ein Fake sein, auch bei Videos ist man sich nicht mehr immer 100% sicher. Der Zweifel wird ein obligatorischer Begleiter bei jeder Bildbetrachtung, schließlich möchte man nicht auf (audio)visuellen Schwindel hereinfallen, und diese Verunsicherung läßt sich leider auch hervorragend instrumentalisieren. Was wahr ist, es aber nicht sein soll, kann als Fake abgetan werden.

Unsere Gesellschaft braucht daher dringend Mittel, gefälschte von echten Abbildungen zu unterscheiden. Auf der Suche nach Möglichkeiten werden derzeit verschiedenen technische Lösungen umgesetzt, welche mal mehr, mal weniger vielversprechend wirken. Sogenannte Content Credentials als transparenter Herkunftsnachweis von digitalen Werken werden schon von einigen Unternehmen und Diensten wie Adobe und OpenAI unterstützt, leider hat Leica bisher als einziger Hersteller das System in einer Kamera, der M11-P, integiert.

Kennzeichnung von "veränderten Inhalten"

Auch Google ist sich der Desinformationsproblematik bewußt und hatte bereits vor längerer Zeit angekündigt, Authentizitäts-Checks und Kennzeichnungen von KI-Content in seiner Suche einführen zu wollen; bei der Bildsuche werden nunmehr "Informationen zu diesem Bild" angeboten, aus denen sich im Idealfall folgern läßt, wenn ein Bild gefälscht ist.

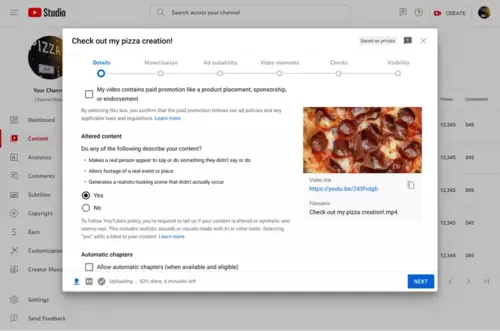

Nun folgt eine Kennzeichnungspflicht für YouTube-Videos, die echt aussehen, es aber nicht sind - gemeint sind "Fake-Videos", obwohl dieses Wort nicht verwendet wird. So muss beim Hochladen eines Clips angegeben werden, ob "Inhalte, die echt zu sein scheinen, stark verändert oder synthetisch generiert wurden", insbesondere wenn sie

- den Anschein erwecken, dass eine echte Person etwas sagt oder tut, das sie nicht gesagt oder getan hat

- veränderte Aufnahmen eines realen Ereignisses oder Orts enthalten

- eine realistisch anmutende Szene, die nicht wirklich stattgefunden hat, enthalten

Diese kennzeichnungspflichtigen, nicht echten Bilder können, aber müssen nicht zwingend mit generativer KI entstanden sein. Sind Clips mithilfe von KI entstanden, aber inhaltlich unrealistisch (z.B. Einhörner sind zu sehen) oder eindeutig als nicht gefilmt erkennbar, müssen sie wiederum nicht ausgewiesen werden. Animierte Videos oder Clips mit Special Effects sind ebenfalls nicht kennzeichnungspflichtig.

Auch wer aus ästhetischen Gründen kleinere Änderungen an echt aufgenommenem Material vornimmt oder sich von einer KI bei der Produktion assistieren läßt, muss dies nicht angeben - erlaubt sind beispielsweise

- Farbanpassungen oder Beleuchtungsfilter

- Beauty-Filter, Spezialfilter, z. B. für Vintage-Effekte oder zur Weichzeichnung des Hintergrunds

- Unterstützung bei der Videoproduktion – z. B. durch Tools, die auf generativer KI basieren –, um ein Videokonzept, ein Skript, ein Thumbnail, einen Titel oder eine Infografik zu erstellen oder zu verbessern

- Erstellen von Untertiteln

- Nachschärfen, Skalieren oder Reparieren von Videos sowie Sprach- oder Audioaufnahmen

Beispiele für Inhalte, Änderungen oder Hilfestellungen zu Videos, die eine Offenlegung durch Creator erfordern, gibt Google auch. Dazu gehört etwa

- die synthetische Generierung von Musik (z. B. mit Creator Music erstellte Musik)

- Sprachaufnahmen, bei denen die Stimme einer anderen Person geklont wird, um sie für Voiceover zu verwenden

- Synthetische Erstellung von zusätzlichem Videomaterial eines realen Ortes

Teilweise werden sehr explizite Beispiele genannt für Fälle, die eine bzw. keine Kennzeichnung erfordern. So ist die "Synthetische Generierung oder Erweiterung eines Hintergrunds, um ein sich bewegendes Auto zu simulieren" erlaubt, während eine "Digitale Anpassung einer bekannten Verfolgungsjagd mit einem Star, der nicht im Originalfilm zu sehen war" nicht zulässig ist ( siehe diesen YouTube Support-Beitrag).

Was echt aussieht, soll auch wahr sein

Google möchte mit dieser Kennzeichnungspflicht Transparenz für das YouTube-Publikum herstellen, sodass immer klar ersichtlich ist, wenn scheinbar realistischer Video-Content manipuliert oder künstlich hergestellt wurde, um gezielte Desinformation zu erschweren. Dies illustriert ganz klar folgende offensichtlich auf stattgefundene Vorfälle zurückgehende Liste von konkreten kennzeichnungspflichtigen Beispielen:

- Den Anschein zu erwecken, dass jemand einen Rat gegeben hat, wenn dies gar nicht der Fall war

- Digitale Modifizierung von Audioaufnahmen, damit es sich so anhört, als hätte ein bekannter Sänger bei einem Liveauftritt den Ton nicht getroffen

- Eine realistische Darstellung eines Tornados oder anderer Wetterereignisse, die sich auf eine reale Stadt zubewegen, was aber nicht stattgefunden hat

- Den Anschein zu erwecken, dass Krankenhausmitarbeiter kranke oder verwundete Patienten abgewiesen hätten

- Darstellung einer Person des öffentlichen Lebens, die etwas stiehlt, das sie nicht gestohlen hat, oder zugegeben hat, etwas zu stehlen, obwohl dies nicht der Fall ist

- Den Anschein erwecken zu lassen, eine echte Person sei verhaftet oder inhaftiert worden

Der Hinweis auf einen "veränderten Inhalt" wird in der Regel in der Videobeschreibung erscheinen, kann aber, bei besonders heiklen Themen wie Gesundheit, Nachrichten, Politik oder Wirtschaft, von Google direkt im Video eingefügt werden. Zunächst soll die Kennzeichnung in der mobilen YouTube-App greifen, danach auch auf Desktop und TV.

Die betreffenden Videos müssen von jenen, die sie hochladen, selbst markiert werden. Wer dieser Pflicht wiederholt nicht nachkommt, riskiert als Konsequenz, vom YouTube-Partnerprogramm ausgeschlossen zu werden oder dass Videos von YouTube entfernt werden. Außerdem behält sich Google vor, manipulierte Videos in eindeutigen Fällen selbstständig zu kennzeichnen, um mögliche Schäden für Zuschauer abzuwenden.

Ob diese neue Kennzeichnungspflicht seine gewünschte Wirkung in der Praxis entfaltet, bleibt zu hoffen - und abzuwarten.