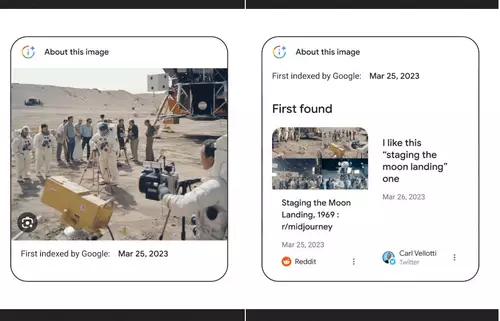

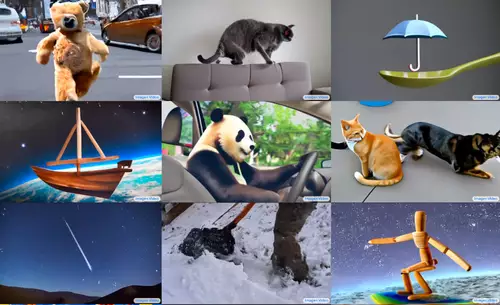

Im Mai hatte Google auf seiner Entwicklerkonferenz angekündigt, sowohl einen Authentizitäts-Check sowie eine Kennzeichnung von KI-generierten Bildern einführen zu wollen. Beides soll helfen, gefälschte Bilder, die im Internet kursieren, als solche zu erkennen. Kurz davor hatten Beispielsweise Fotos von Papst Franziskus in modischem Styling für einiges Aufsehen gesorgt - sie waren künstlich generiert, sahen aber täuschend echt aus und öffneten vielen die Augen für die erstaunlichen Fähigkeiten der KI-Generatoren.

Laut Google hatten damals auch andere Dienste wie Midjourney oder Shutterstock zugesagt, in Zukunft die angestrebte Kennzeichnung einzuführen, welche allerdings im Grunde nur eine relativ zahnlose Metadatenkennung wäre.

Einen Schritt weiter geht wie es scheint nun eine Vereinbarung, welche sieben große KI-Unternehmen am Freitag auf einem Treffen mit US-Präsident Biden trafen. Vor Ort waren Vertreter von Amazon, Anthropic, Google, Inflection, Meta, Microsoft und OpenAI, um über dringende Fragen rund um die Sicherheit, Verantwortung und das Vertrauen bezüglich der neuen KI-Technologie zu beraten.

Die genannten Unternehmen haben sich laut dem Weißen Haus freiwillig verpflichtet, bei künftigen KI-Entwicklungen verschiedene Sicherheitsaspekte zu berücksichtigen, welche in einem vierseitigen Dokument beschrieben werden. Es geht dabei u.a. um das ausgiebige Testen der Systeme, um so ihr inhärentes Gefahrenpotential einschätzen zu können und auch darum, Maßnahmen gegen einen möglichen Mißbrauch zu ergreifen.

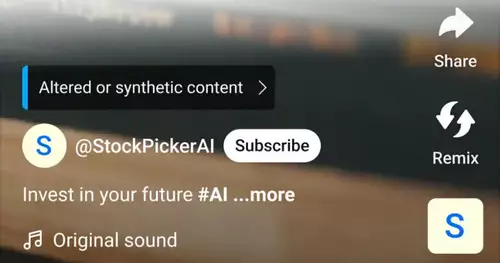

Ebenfalls Teil der Vereinbarung sind Schritte, um das Vertrauen der Menschen in die neue KI-Technologie zu stärken. Wichtig dafür sei unter anderem die Möglichkeit zu erkennen, ob audiovisuelle Inhalte von KIs manipuliert oder gar generiert wurden. Um dies zu ermöglichen, erklären sich die Unternehmen demnach bereit, robuste Systeme zu implementieren, um die Herkunft von Bildern nachvollziehbar zu machen (wie schon damals von Google angestoßen) - Wasserzeichen werden hier ausdrücklich und ziemlich konkret erwähnt. Der entsprechende Passus lautet (automatisch übersetzt):

"Die Unternehmen, die diese Verpflichtung eingehen, erkennen an, dass es für die Menschen wichtig ist, nachvollziehen zu können, wenn Audio- oder visuelle Inhalte von KI generiert wurden. Um dieses Ziel zu erreichen, verpflichten sie sich, robuste Mechanismen zu entwickeln, einschließlich Herkunftsnachweis- und/oder Wasserzeichensystemen für Audio- oder visuelle Inhalte, die von einem ihrer öffentlich zugänglichen Systeme in einem Umfang erstellt wurden, der nach der Entwicklung des Wasserzeichensystems eingeführt wird.

Sie werden auch Werkzeuge oder APIs entwickeln, um festzustellen, ob ein bestimmter Inhalt mit ihrem System erstellt wurde. Audiovisuelle Inhalte, die sich leicht von der Realität unterscheiden lassen oder die so gestaltet sind, dass sie leicht als von einem KI-System eines Unternehmens erzeugt erkennbar sind - wie etwa die Standardstimmen von KI-Assistenten - fallen nicht in den Geltungsbereich dieser Verpflichtung. Das Wasserzeichen oder die Herkunftsdaten sollten eine Kennung des Dienstes oder Modells enthalten, der/das den Inhalt erstellt hat, aber sie müssen keine identifizierenden Nutzerinformationen enthalten.

Generell erklären sich Unternehmen, die diese Verpflichtung eingehen, bereit, mit Branchenkollegen und Normungsgremien zusammenzuarbeiten, um einen technischen Rahmen zu entwickeln, der es Nutzern ermöglicht, von Nutzern erzeugte Audio- oder visuelle Inhalte von Audio- oder visuellen Inhalten zu unterscheiden, die von KI erzeugt wurden."

Bevor nun jemand wegen dieser Vereinbarung gleich die Korken knallen läßt, sei daran erinnert, dass dies lediglich Absichtserklärungen und freiwillige Selbstverpflichungen sind - im Falle des Nicht-Einhaltens sind keine Strafen vorgesehen (die Gesetzgebung hinkt noch hinterher). Außerdem fehlten beim Treffen wichtige Akteure, beispielsweise Midjourney und Stability AI, das Unternehmen hinter Stable Diffusion. Beide bieten mächtige KI-Bildgeneratoren an, letzterer sogar unter Open Source. Eine KI-Charta, deren Grundstein hier bestenfalls gelegt wurde, trägt natürlich eigentlich nur dann, wenn auch alle überzeugt werden können, mitzumachen.